Ich weiß ja nicht wie es Dir geht, aber ich bin immer auf der Suche nach neuen Wegen, um meine SEO zu verbessern.

Ich bin jetzt schon zeit über zehn Jahren im digitalen Marketing tätig. Ich hab es schon tausend mal gehört: „Die SEO ist tot!“

Sie ist noch immer ein sehr wichtiger Bestandteil jeder Webseite.

Darum finde ich gerne neue, interessante und unbekannte Methoden, um meine SEO zu verbessern.

Heute teile ich eine SEO-Technik mit Dir, die eher unbekannt ist, aber viel bewirken kann.

Die Berichte der Crawling-Statistiken der Google Search Console.

Du weißt bestimmt schon, dass die Google Search Console, auch GSC genannt, zu meinen Lieblingstools für die Verwaltung von Webseiten gehört.

Du hast sie wahrscheinlich auch schon mal benutzt. Vielleicht bist Du sogar ein GSC Experte.

Es steckt aber viel mehr hinter der GSC, als es auf den ersten Blick den Anschein hat.

Ich benutze viele GSC-Funktionen, die andere Leute eher selten benutzen.

Die Crawling-Statistiken werden häufig übersehen.

Die Seite ist winzig und besteht aus lediglich drei Diagrammen und ein paar Daten. Du solltest sie aber auf keinen Fall unterschätzen.

Denn hier kannst Du ablesen, wie der Crawler der Google-Suchmaschine auf Deine Webseite reagiert. Wenn Du das Meiste aus Deinem SEO herausholen willst, sind diese Informationen wichtig.

Ich zeige Dir jetzt, wie Du die Crawling-Statistiken benutzen kannst, um Dein SEO zu verbessern und Einblicke in Werte zu erhalten, die Du nirgends sonst finden kannst.

Was sind die Crawling-Statistiken?

Als erstes möchte ich Dir kurz erklären, was es mit den Crawling-Statistiken auf sich hat.

Du musst die Google Search Console aufrufen und die richtige Property aufrufen, um auf diese Statistiken zugreifen zu können.

Klick in der linken Seitenleiste auf Crawling.

Wähle dann Crawling-Statistiken aus dem Menü aus.

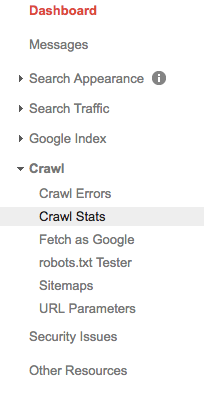

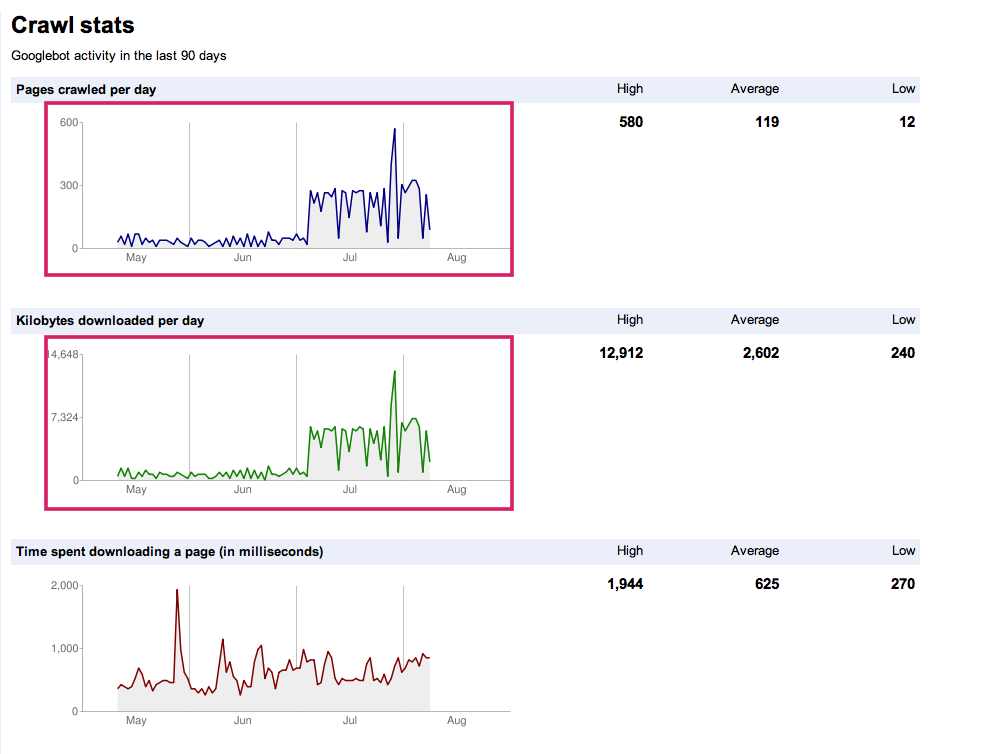

Jetzt bist Du auf der Seite mit den Berichten zu Deinen Crawling-Statistiken! Diese Seite sollte ungefähr so aussehen:

Ich gebe zu, das sieht auf den ersten Blick nicht sehr hilfreich aus. Man kann nicht sofort erkennen, wie diese Daten Deiner SEO zu Gute kommen können.

Darum wollen wir uns zunächst anschauen, was die Werte bedeuten.

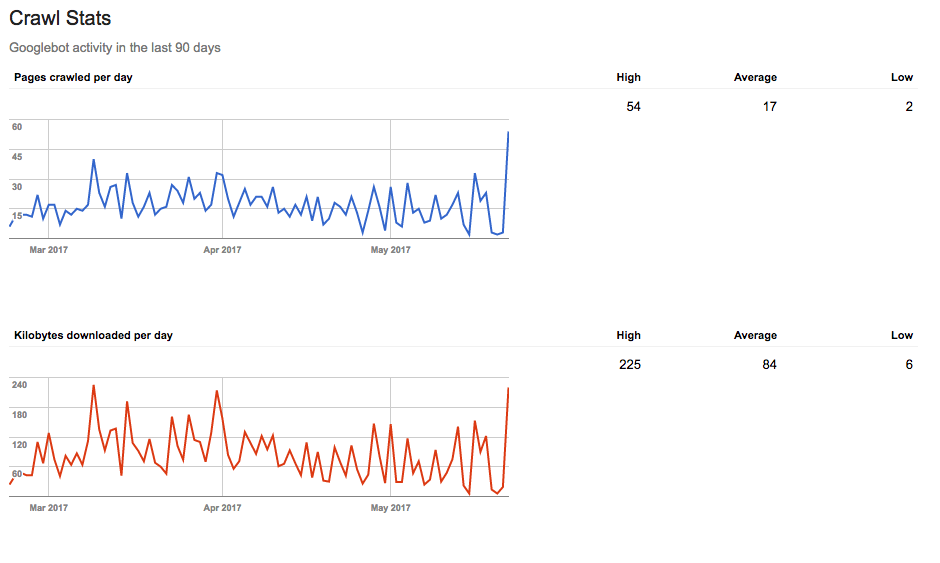

Es handelt sich hierbei um die Messwerte Deiner Crawling-Rate.

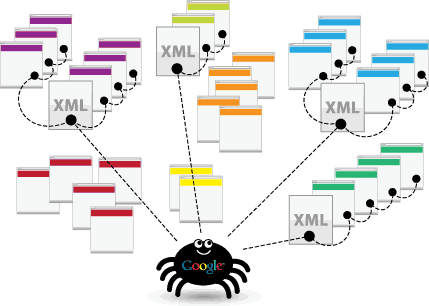

Die Crawling-Rate verrät uns, wie oft die Such-Bots Deine Webseite durchsuchen. In diesem Fall sehen wir die Aktivität der Such-Bots von Google.

Hier ist die Definition von Google:

Eine schnelle Crawling-Rate ist fast immer wünschenswert, denn dann können die Bots Deine Webseite schneller und einfacher indexieren.

Und wenn Deine Webseite mehr Aufmerksamkeit von Google bekommt, dann steigt Dein Ranking in den SERPs.

Darum sind die Crawling-Statistiken so wichtig. Wenn Deine Crawling-Rate niedrig ist, dann leidet Dein SEO darunter.

Wenn Deine Crawling-Rate plötzlich nach oben schießt, dann könnte etwas mit Deiner Seite nicht stimmen.

Darum sollte man seine Crawling-Rate immer gut im Auge behalten.

Die Diagramme machen jetzt vielleicht noch nicht viel Sinn, das ist aber nicht schlimm!

Wir schauen uns jetzt an, wie wir diese Werte interpretieren können.

Wie man die Diagramme lesen muss

Die Seite der Crawling-Statistiken ist in drei Bereiche unterteilt:

- Pro Tag gecrawlte Seiten

- Pro Tag heruntergeladene Kilobyte

- Downloadzeit einer Seite (in Millisekunden)

Alle drei Statistiken sind gleichermaßen wichtig, darum solltest Du Dir immer alle drei zusammen ansehen.

Ich beschäftige mich noch mit allen drei Bereichen.

Pro Tag gecrawlte Seiten

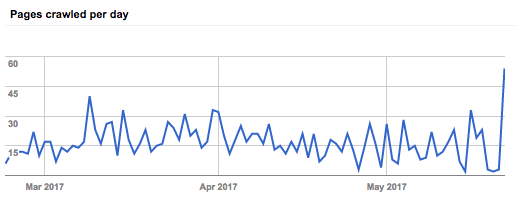

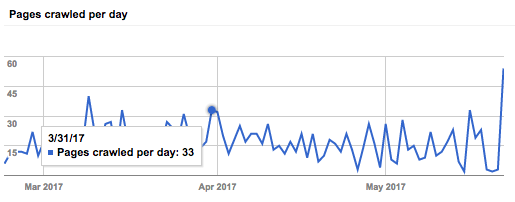

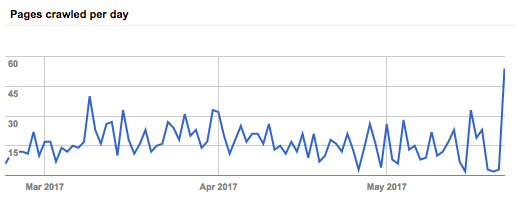

Diese Statistik zeigt Dir, wie viele Seiten der Googlebot jeden Tag crawlt. Du kannst die Ergebnisse der letzten 90 Tage einsehen:

Wenn Du einen bestimmten Tag einsehen willst, kannst Du mit dem Mauszeiger über das Diagramm fahren, um die Ergebnisse zu sehen:

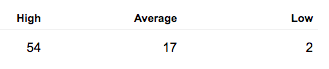

Auf der rechten Seite siehst Du Deine hohe, durchschnittliche und niedrige Crawling-Rate.

Jetzt kommt der knifflige Teil.

Die Crawling-Rate unterscheidet sich von anderen Kennzahlen, wie zum Beispiel der Domain Authority. Du hast keinen Einfluss darauf, wie oft Google Deine Webseite durchsucht.

Du kannst aber versuchen zu verstehen, warum es Abweichungen gibt, besonders wenn es zu sehr großen Abweichungen innerhalb weniger Tage kommt.

Da die Crawling-Rate auch Aufschluss darüber gibt, wie schnell und Bot-Freundlich Deine Webseite ist, ist die sie ein guter Indikator dafür, ob Deine Seite einfach zu crawlen ist, oder nicht. (Sie sollte einfach zu crawlen sein!)

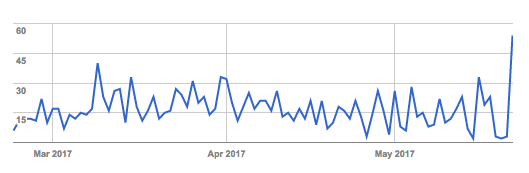

Du willst eine konstante Crawling-Rate haben. Das sollte ungefähr so aussehen:

Es gibt immer mal wieder ein paar Ausreißer, aber im Großen und Ganzen bleibt die Crawling-Rate konstant.

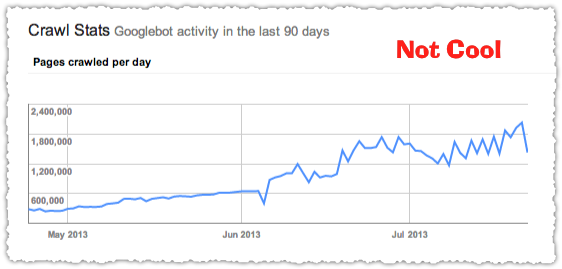

Wenn Du so etwas siehst:

Dann hast Du ein Problem.

Alle drei Diagramme ähneln sich. Um Dich mit der Crawling-Rate zu beschäftigen, ist das erste Diagramm, die pro Tag gecrawlten Seiten, ausschlaggebend.

Starke Ausreißer und Unregelmäßigkeiten könnten ein Anzeichen dafür sein, dass mit Deiner Seite etwas nicht stimmt.

Was solltest Du tun, wenn das bei Dir der Fall ist?

Wir schauen uns die unterschiedlichen Szenarien jetzt mal an.

Wenn der Graph plötzlich abfällt, könnte das folgende Ursachen haben:

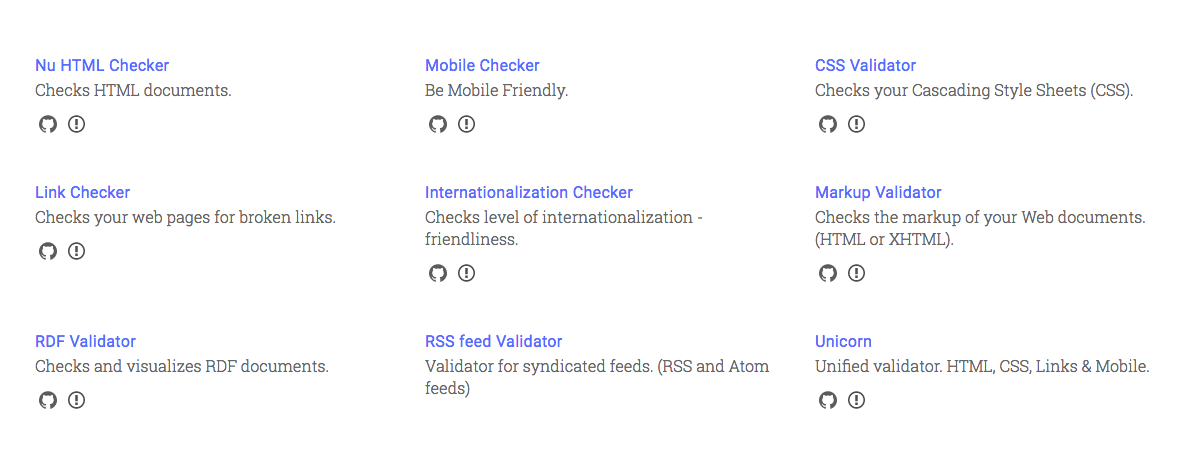

1. Vielleicht hast Du einen kaputten Code (z.B. HTML) oder nicht unterstützte Inhalte auf Deiner Webseite.

Wenn Du erst kürzlich Deinen Code bearbeitet hast, könnte das das Problem sein.

Du kannst Deinen Code mit einem der Validatoren von W3 überprüfen, um zu sehen, ob er funktioniert.

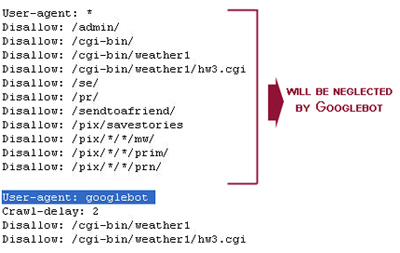

2. Deine Robots.txt Datei könnte zu viel blockieren.

Man sollte seine Robots.txt Datei immer nur sehr sorgfältig überarbeiten, denn man kann Informationen, die Google braucht, um eine Seite zu durchsuchen, aus Versehen blockieren.

Wenn Deine Robots.txt Datei riesig ist:

Musst Du sie vielleicht überarbeiten.

3. Deine Webseite hat alte Inhalte.

Es ist kein Geheimnis, dass Google frische Inhalte liebt.

Und so funktioniert es (zumindest in der Theorie): Wenn Du eine Veränderung an Deiner Webseite vornimmst, wird Google darüber informiert und crawlt Deine Seite erneut.

Deine Webseite wird jedes Mal neu indexiert, wenn der Google-Bot Deine Seite crawlt.

Und wenn Deine Seite super ist, dann kannst Du Dir einen Ranking-Schub erhoffen.

Wenn Deine Webseite aber zu viele alte Inhalte hat, wir sie nicht so häufig durchsucht und die Crawling-Rate sinkt.

Das willst Du um jeden Preis verhindern.

Du solltest Deine Webseite regelmäßig mit frischen und hilfreichen Informationen füllen.

Wenn die Inhalte Deiner Seite abgestanden sind, dann wird sie ganz sicher auch weniger gecrawlt und bekommt weniger Klicks.

Denk immer daran, dass Du Deine Seite nicht nur für die Suchmaschinen auf Vordermann bringen musst. Du machst es auch für die Nutzer.

Wenn Du regelmäßig neue Inhalte veröffentlichst, dann wird Deine Webseite auch häufiger von Google durchsucht und von mehr Leuten gesehen.

Wenn der Graph plötzlich nach oben schießt, könnte das folgende Gründe haben:

1. Du hast neue Inhalte veröffentlicht, oder den Code Deiner Seite überarbeitet.

Auch wenn Du nicht bewusst versuchst erneut gecrawlt zu werden, könnte es trotzdem passieren, besonders dann, wenn Du etwas Neues veröffentlichst.

Das könnte ein neuer Inhalt oder ein neues Stück Code sein.

Wenn Du Deine Seite erst neulich überarbeitet hast und Dein Diagramm dann plötzlich nach oben schnellt, liegt das wahrscheinlich an den neuen Informationen auf der Webseite.

2. Deine Robots.txt Datei lässt zu, dass die Crawl-Bots viele Deiner Inhalte crawlen.

Wenn Du Deine Robots.txt Datei noch nie überarbeitet hast, dann hast Du wahrscheinlich keine, oder eine Grundlegende.

Das heißt, dass die Such-Bots immer Deinen gesamten Inhalt durchsuchen.

Wollen wir das? Jein. das kommt immer ganz darauf an, was Du von den Bots willst. Lies Dir diesen Artikel durch, wenn Du Details willst.

Das sind die Hauptgründe für die Ausreißer im Diagramm.

Wie gesagt, man sollte immer eine konstante Crawling-Rate anstreben.

Dein Diagramm sollte also in etwas so aussehen:

Wenn Dein Diagramm mehrere Höhen und Tiefen hat, ist das nicht so schlimm.

Wenn Du aber über einen längeren Zeitraum Inaktivität feststellst…

…oder dramatische Veränderungen siehst…

…hast Du wahrscheinlich ein Problem, das behoben werden muss.

Noch eine letzte Sache: Benutze die Werte auf der rechten Seite, um die durchschnittliche Crawling-Rate Deiner Webseite zu bestimmen.

Dafür gibt es keine Formel; Du musst die Werte über einen längeren Zeitraum hinweg beobachten.

Da die Crawling-Statistiken nur Daten der vergangenen 90 Tage enthalten, kannst Du Deine Werte alle 90 Tage vergleichen, um eine gute Übersicht zu bekommen und einen durchschnittlichen Wert zu ermitteln.

Ich erkläre Dir jetzt, was ich damit meine.

Du hast also vier Mal die Werte einer 90-Tage-Periode ermittelt und die Durchschnittswerte lagen bei 40, 52, 49 und 45.

In diesem Fall beträgt der Durchschnittswert des Jahres 46,5.

Du musst die Crawling-Rate der letzten 90-Tage und den Durchschnittswert aller 90-Tage-Perioden überwachen.

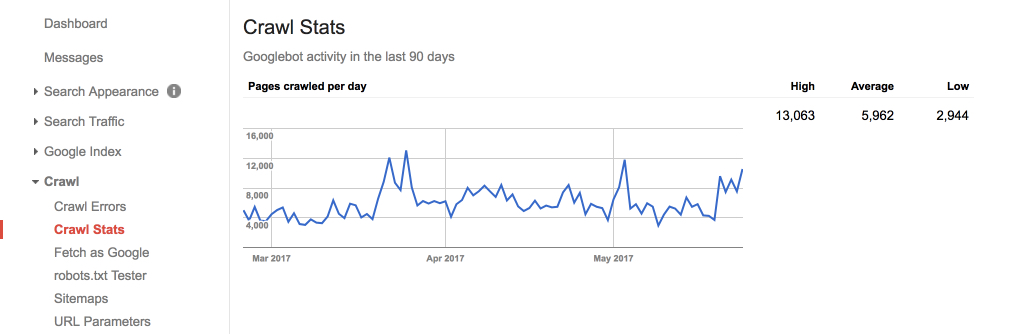

Mein Durchschnittswert liegt bei 5.962.

Meine Seite ist umfangreich, weil ich mehrmals pro Woche neue Inhalte veröffentliche. Lass Dich also nicht entmutigen, wenn Deine Werte niedriger ausfallen.

Wenn Deine Webseite noch neu ist oder über weniger Verlinkungen verfügt, wird sie wahrscheinlich auch weniger häufig gecrawlt. Wenn Deine Webseite wächst, steigt auch Deine Crawling-Rate.

Das Diagramm der pro Tag gecrawlten Seiten ist einer der wichtigsten Bereiche der Crawling-Statistiken, wenn nicht sogar der Wichtigste.

Wie kannst Du Deine Crawling-Rate optimieren?

Wenn Deine Crawling-Rate niedrig ausfällt oder zu viele Abweichungen aufweist, solltest Du daran arbeiten, eine konstante Crawling-Rate zu bekommen.

Du solltest Ausreißer, die von Problemen hervorgehoben werden, auf jeden Fall beseitigen, aber Du musst Deine Webseite auch für eine auf lange Sicht konstante Crawling-Rate optimieren.

Eine Möglichkeit, um die Crawling-Rate zu optimieren, haben wir bereits angesprochen: fische Inhalte.

Je häufiger Du neue Inhalte Veröffentlichst, desto höher ist Deine Crawling-Rate.

Das reicht aber noch nicht aus.

Die Google-Bots benutzen komplizierte Algorithmen, um die Qualität Deiner Webseite zu bestimmen.

Je besser Deine Inhalte sind, desto eher verschafft Dir der Google-Bot einen Vorteil in den SERPs.

Das kannst Du am besten mit langen und ausführlichen Inhalten erreichen. Diese Inhalte werden erwiesenermaßen besser platziert und Deine Nutzer werden sie ebenfalls lieben.

Du kannst aber noch andere Tricks anwenden.

Einer dieser Tricks stammt von Brian Dean von Backlinko.

Er sagt, Du solltest Deine alten Inhalte erneut veröffentlichen. Die Idee ist wirklich genial, denn auf diese Weise holst Du das Meiste aus Deinen bereits fertigen Inhalten heraus.

Deine Nutzer sehen Deine Inhalte dann, als wären sie gerade erst veröffentlicht worden:

Dennoch sind es alte Inhalte.

Da Du sie aber überarbeitet hast, werden sie erneut vom Google-Bot gecrawlt und Deine Crawling-Rate steigt.

Du kannst fast all Deine Probleme lösen, indem Du immer frische Inhalte veröffentlichst. Wenn Du aber nicht die gewünschten Ergebnisse siehst, solltest Du Deine älteren Inhalte überarbeiten und erneut veröffentlichen.

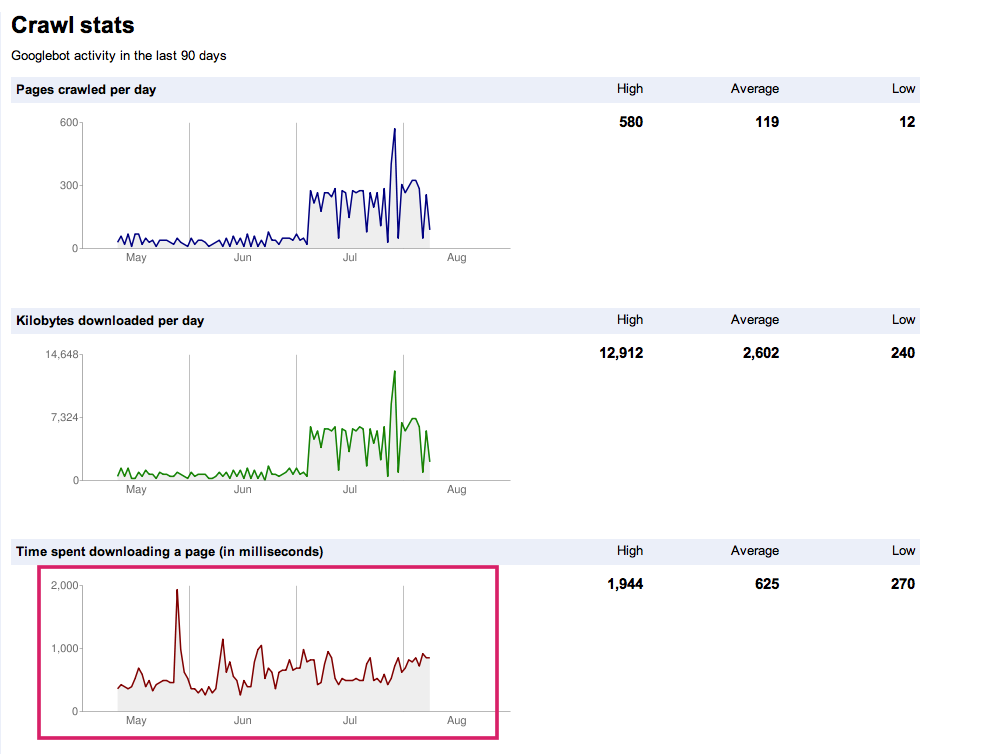

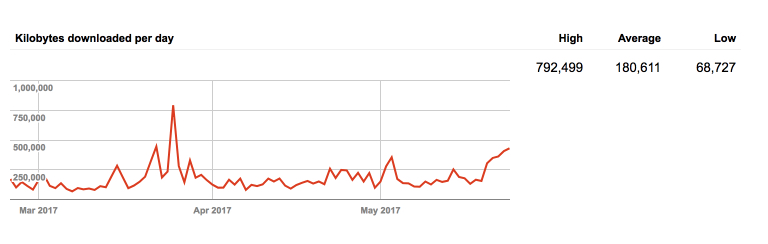

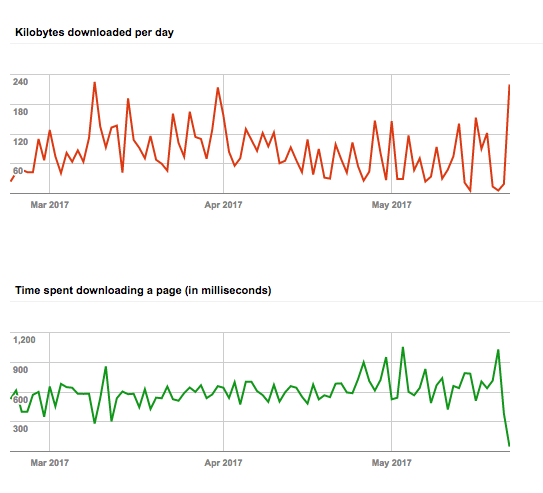

Pro Tag heruntergeladene Kilobytes

Du fragst Dich jetzt wahrscheinlich, was es damit auf sich hat. Was wird denn da heruntergeladen?

Jedes Mal, wenn der Such-Bot Deine Webseite besucht, lädt er Deine Seite für den Indexierungsprozess herunter.

Dieser Wert gibt also an, wie viele Kilobytes der Google-Bot heruntergeladen hat.

Der Wert fällt immer unterschiedlich aus, je nachdem, wie groß Deine Seite ist. Wenn Deine Webseite klein ist, dann muss Google auch nicht so viel herunterladen, usw.

Die Statistik ist der wahrscheinlich eher weniger hilfreiche Bereich der Crawling-Statistiken, dennoch kannst Du Erkenntnisse gewinnen, die Dir bei der Analyse Deiner Seitenleistung behilflich sein können.

Wenn Dein Wert immer sehr hoch ausfällt:

Dann crawlt der Google-Bot Deine Seite sehr oft.

Da der Google-Bot Deine Seite jedes Mal erneut herunterladen muss, weist ein hoher Wert darauf hin, dass Google Deine Webseite häufig durchsucht.

Ein hoher Wert ist aber auch ein zweischneidiges Schwert.

Das bedeutet nämlich auch, dass Google länger braucht, um Deine Seite zu crawlen. Wenn Deine Seite aber schnell heruntergeladen werden kann, ist sie weniger schwer und leichter zu durchsuchen.

Darum solltest Du Dir dieses Diagramm auch ruhig mal etwas genauer ansehen, um zu erfahren, wie schnell der Google-Bot Deine Seite durchsuchen und indexieren kann.

Du kannst dieses Diagramm auch zusammen mit dem ersten Diagramm benutzen, um zu sehen, ob Google Deine Webseite gefällt.

Downloadzeit einer Seite (in Millisekunden)

Diese Statistik ist ein bisschen irreführend.

Du denkst jetzt wahrscheinlich, dass es etwas mit Deiner Seitengeschwindigkeit zu tun hat.

Die Seitengeschwindigkeit ist wichtig, aber noch längst nicht alles, was hier gemessen wird.

Laut John Mueller von Google, kannst Du hier sehen, wie lange der Google-Bot braucht, um HTTP-Anfragen zum Crawlen Deiner Seite zu stellen.

Ganz schön enttäuschend, ich weiß.

Du kannst diese Informationen aber dennoch nutzen.

Hier sind niedrige Werte besser.

Wenn Deine Werte niedrig ausfallen, dann verbringt der Google-Bot nicht so viel Zeit auf Deiner Seite und kann sie darum auch schneller durchsuchen und indexieren.

Du hast keinen Einfluss auf diese Kennzahlen, kannst aber ablesen, wie schnell Google Deine Seite durchsucht.

Du kannst diese Informationen zusammen mit dem Diagramm der heruntergeladenen Kilobytes pro Tag benutzen. Das funktioniert folgendermaßen.

Schau Dir beide Diagramme Pro Tag heruntergeladene Kilobyte und Dauer des Herunterladens einer Seite (in Millisekunden) an.

Nehmen wir einfach mal an, sie sehen so aus:

Du musst darüber nachdenken, wie diese beiden Diagramme zueinander in Beziehung stehen.

Wenn beide Durchschnittswerte hoch ausfallen, verbringt der Google-Bot viel Zeit auf Deiner Seite. Das ist nicht ideal.

Da Du nicht beeinflussen kannst, wie lange der Google-Bot braucht, um eine HTTP-Anfrage zu stellen, musst Du Einfluss darauf nehmen, wie viele Kilobytes Google herunterlädt.

Du kannst zum Beispiel unwichtige Seiten vom Crawling ausschließen. Du könntest Deine Robots.txt Datei überarbeiten. (Lies Dir diesen Artikel durch, wenn Du Hilfe dabei brauchst).

Du kannst unwichtige Seiten und nutzlosen Code von Deiner Webseite entfernen. Du musst aber vorsichtig sein, weil all Deine Inhalte und jeder Code Einfluss auf Dein SEO haben.

Es ist aber nicht so schlimm, wenn Google viele Kilobytes herunterlädt. Das sollte Dir keine schlaflosen Nächte bereiten.

Fazit

Ich will ganz ehrlich mit Dir sein.

Als ich mir die Crawling-Statistiken zum ersten Mal angeschaut habe, habe ich gedacht: “Ist das schon alles?”

Die sind nicht sehr beeindruckend.

Vielleicht bist Du schon mal zufällig auf dieser Seite gelandet und hast Dir nichts weiter dabei gedacht. Da die Seite aber schwer zu finden ist, hast Du Dich wahrscheinlich noch nicht weiter mit ihr beschäftigt.

Wenn Du aber erst einmal weißt, was die Statistiken bedeuten, geht Dir ein Licht auf. Plötzlich stehen Dir neue Möglichkeiten zur Verfügung.

Die Seite ist wirklich extrem nützlich, obwohl sie so wenig Informationen enthält.

Sie enthält lediglich drei Diagramme und trotzdem ist sie eine Goldmine an Informationen. Wenn Du Dich mit der SEO beschäftigst, musst Du Dir die Seite unbedingt anschauen.

Und das Beste daran ist, dass sie kostenlos ist. Wenn Du die Google Search Console also noch nicht benutzt, solltest Du jetzt damit anfangen.

Wenn die Crawling-Statistiken schon zum festen Bestandteil Deiner Langzeit-SEO-Strategie geworden sind, kannst Du Deine Mitbewerber ausstechen und Dir einen einzigartigen Vorteil sichern.

Mit den Berichten der Crawling-Statistiken kannst Du die Beziehung zwischen Deiner Webseite und dem Google-Bot besser verstehen.

Stell es Dir einfach wie eine Art Beziehungstherapie vor. Du kannst überprüfen, wie es um die Beziehung steht und ggf. Veränderungen vornehmen.

Du solltest Dir auch mal die anderen Bereiche der Google Search Console ansehen. Fang am besten mit den Crawling-Statistiken an und arbeite Dich dann Stück-für-Stück durch die GSC.

Hast Du die Crawling-Statistiken schon mal benutzt? Willst Du jetzt damit anfangen?

Kommentare (1)