¿Alguna vez te has preguntado por qué Google hace tantas actualizaciones a su algoritmo?

¿Comprendes de qué tratan los cambios del algoritmo de Google?

Ningún especialista en SEO o marketer de contenidos, puede predecir con precisión cómo se verá un cambio de algoritmo en el futuro. Incluso algunos empleados de Google no entienden todo lo que pasa con el motor de búsqueda más dominante de Internet.

Toda esta confusión representa un problema para quienes tienen páginas web y son conocedores del tema: Puesto que hay alrededor de 200 factores de clasificación, ¿en cuáles deberías enfocar tu atención después de una actualización importante en el algoritmo de Google?

Google ha publicado cuatro importantes actualizaciones de su algoritmo, llamados (en orden cronológico) Panda, Penguin, Hummingbird y Pigeon. En medio de estos grandes cambios, los ingenieros de Google también hicieron algunos ajustes a los que no se les hizo mucha publicidad, pero que impactan el posicionamiento de tu página web en los resultados de búsqueda.

Descripción General de los Cambios en el Algoritmo de Google

Antes de que puedas tener una compresión completa del impacto que tiene cada una de las actualizaciones del algoritmo, necesitas tener un conocimiento práctico de lo que es el algoritmo de un motor de búsquedas.

La palabra «algoritmo» se refiere a la lógica sobre la que se basa un proceso paso a paso para resolver un problema. En el caso de un motor de búsqueda, el problema es «cómo encontrar las páginas web más relevantes para un conjunto particular de palabras clave (o términos de búsqueda)». El algoritmo es la forma en la que Google encuentra, clasifica y envía los resultados relevantes.

Google es el motor de búsqueda #1 en la web y llegó a ese puesto por su enfoque de entregar el mejor resultado por cada búsqueda. Como dice Ben Gomes, el Vicepresidente de Ingeniería de Google: «nuestro objetivo es conseguirte más rápido la respuesta exacta que buscas» .

Desde el comienzo, en una apuesta por mejorar su habilidad de entregar esas respuestas correctas con rapidez, Google empezó a actualizar su algoritmo de búsqueda – a veces de forma drástica – y como consecuencia, esto ha cambiado la manera en la que entrega resultados relevantes a los usuarios que realizan las búsquedas.

Debido a estos cambios en el algoritmo, muchos sitios fueron penalizados, su posición bajó en resultados de búsqueda, mientras que otros sitios experimentaron una subida de su tráfico orgánico y un mejor posicionamiento.

Un resumen de la historia: Los cambios en el algoritmo pueden ser grandes o pequeños – la mayoría son pequeños. En 2014, Google realizó aproximadamente 500 cambios a su algoritmo. Después de cada uno de esos ajustes una gran cantidad de sitios perdieron posicionamiento.

Diez años antes, en Febrero de 2004, Google anunció la actualización Brandy. Un importantísimo cambio en el algoritmo. Los puntos de enfoque más grandes de Brandy eran una mayor atención en los textos de anclaje (anchor texts) y algo llamado «Indexación Semántica Latente» (Latent Semantic Indexing, LSI en inglés) – básicamente, es mirar otras páginas en el mismo sitio para evaluar si contienen los mismos términos de búsqueda, además de la página indexada.

Eventualmente el enfoque de Google cambió hacia el análisis de palabras clave e intenciones de búsqueda, en vez de preocuparse solamente por las palabras clave.

Yendo mucho más atrás, Google hizo un número de cambios en el año 2000, incluyendo el lanzamiento de la barra de herramientas de Google y una modificación significativa conocida como «Google Dance» (Baile Google). Sin embargo, en cuanto al impacto del SEO en sitios web de negocios, esas actualizaciones no tuvieron un impacto relevante en los resultados de búsquedas.

Si quieres estar actualizado sobre los cambios, puedes revisar toda la historia de los cambios en el algoritmo de Google.

Google necesita grandes volúmenes de información para poder tomar mejores decisiones. Cuanto más relevantes sean los resultados que una persona obtiene cuando realiza búsquedas para un término específico, más precisa será la información que Google podrá extraer y entregársela a otros usuarios.

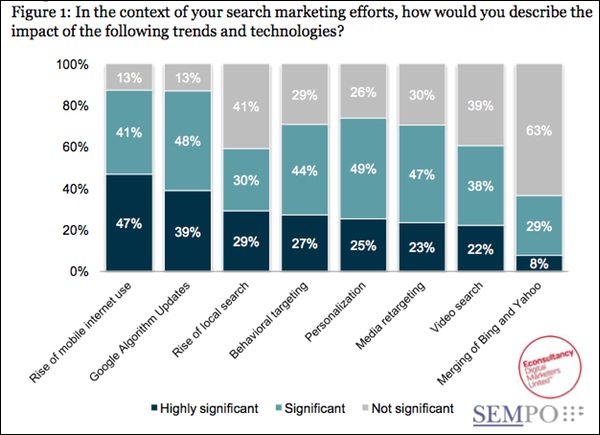

Por eso estos cambios han impactado también los resultados de búsquedas en dispositivos móviles. Los cambios recientes de Google junto con el crecimiento explosivo del uso de dispositivos móviles, han sido significativos para profesionales del marketing.

En este artículo nos enfocaremos en cuatro principales cambios del algoritmo de Google. Cada una de estas actualizaciones han tenido, y continúan teniendo, un impacto significativo en el marketing de motores de búsqueda, el SEO de sitios web y en la estrategia general de contenidos de tu sitio web. Específicamente discutiremos los siguientes:

- La actualización Panda

- La actualización Penguin

- La actualización Hummingbird

- Y el cambio de algoritmo más reciente, Google Pigeon

Los Principales Beneficios de los Cambios en el Algoritmo del Google

En los dos últimos años, hemos visto el efecto positivo en SEO de los cambios de Panda, Penguin, Hummingbird y Pigeon. Algunos de estos beneficios son:

El compromiso de Google de enfocarse en el usuario – Recuerda el objetivo de Google: ayudar a cada usuario a encontrar la información correcta lo más rápido posible. Estas actualizaciones, especialmente Panda, afianzan aún más el compromiso de Google con sus usuarios.

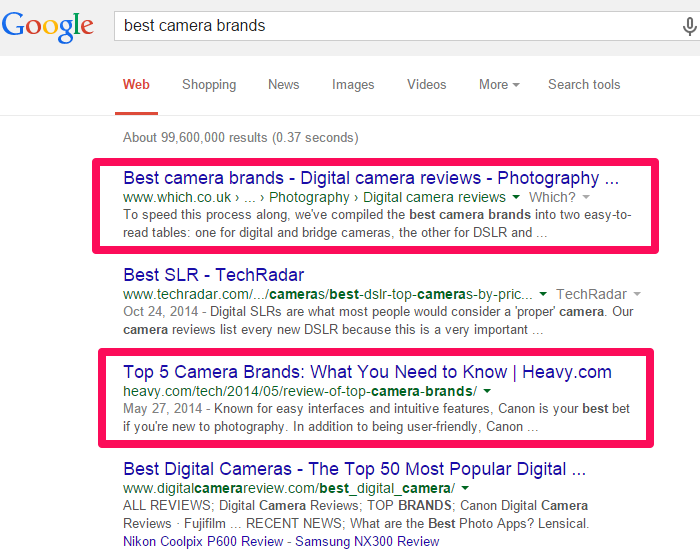

Aunque Google tiene aún mucho trabajo por hacer para mejorar los resultados de búsqueda, las probabilidades de que obtengas resultados relevantes e informativos en la primera página de Google cuando realizas una búsqueda son muy buenas.

Por ejemplo, digamos que buscas las mejores marcas de cámaras. Tus primeros resultados seguramente incluirán esos términos de búsqueda o sus sinónimos más cercanos:

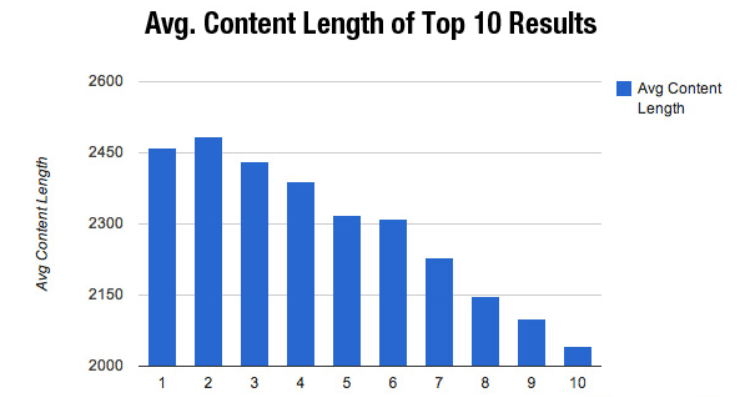

Posicionamiento mejorado para contenido detallado (in-depth content): – serpIQ está de acuerdo con que en el SEO de hoy, «más es mejor». El contenido más extenso tiende a dominar los resultados de búsquedas hoy en día.

Antes de Google Panda, el contenido menos extenso se posicionaba muy bien, esto sucedía con frecuencia. Los redactores de contendido podían juntar 300 palabras por artículo o blog, introducir algunos enlaces con alto PR (PageRank, califica la relevancia de una página web) y terminar ocupando el puesto #1 en Google – y quedarse allí por meses. Esos días terminaron, así que como dice Brian Dean, publica contenido extenso si quieres mejorar tu ranking.

Las granjas de contenidos (o content farms, los sitios que generan con frecuencia y rapidez contenido poco extenso y de mala calidad) fueron los mayores culpables. Sitios como EzineArticles, ArticleAlley y Buzzle perdieron posicionamiento, aun teniendo nombres de dominios con mucha antigüedad. Su contenido no pudo proveer soluciones significativas, relevantes y duraderas.

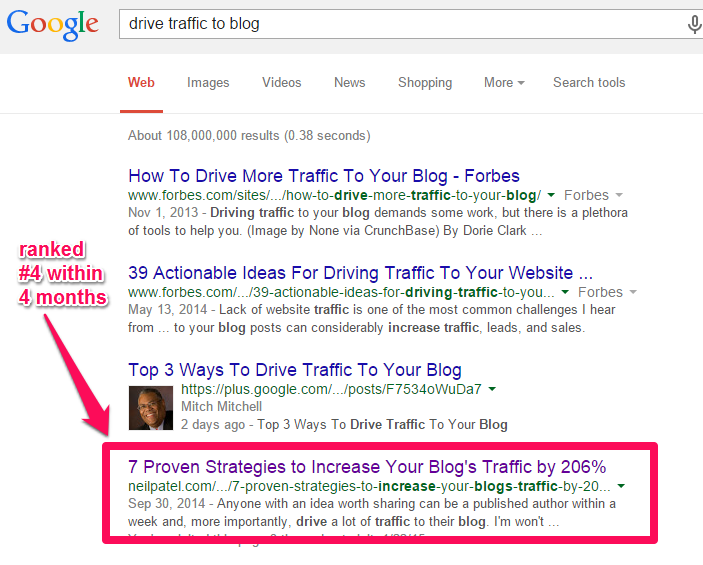

Hoy por hoy, Google da preferencia a porciones de contenidos detallados o profundos (in-deph content) con mayor probabilidad de continuar siendo útiles en el tiempo. Por ejemplo, uno de los artículos en este blog ocupa el puesto #4 por una frase clave muy buscada:

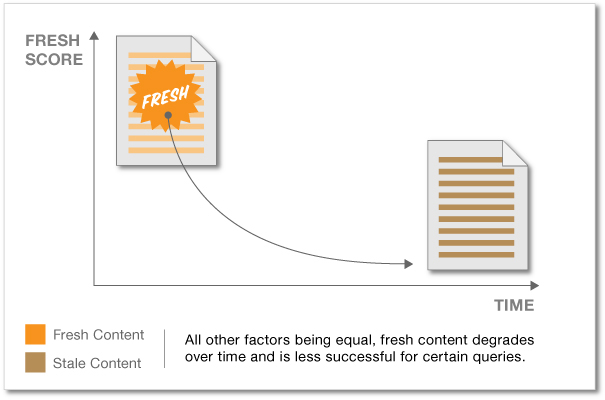

La ventaja del contenido nuevo – Cuando publicas contenido nuevo, Google le da una puntuación a tu sitio web. En el tiempo, esta puntuación se desvanece y entonces tu sitio requerirá más contenido nuevo.

Cyrus Shepard dice sobre eso que “la puntuación dado al contenido nuevo puede impulsarlo para ciertas búsquedas» aunque en el tiempo descienda. La puntuación por contenido nuevo se determina en tu sitio web inicialmente cuando la spider de Google examina tu página y la indexa.

Por lo tanto, si siempre estás actualizando tu blog o sitio con contenido relevante, bien investigado y detallado (más de 2.000 palabras), entonces deberías esperar mejor posicionamiento y visitas orgánicas de Google. Por el contrario, sitios que publican con irregularidad o esporádicamente, difícilmente mantendrán una sólida posición en Google.

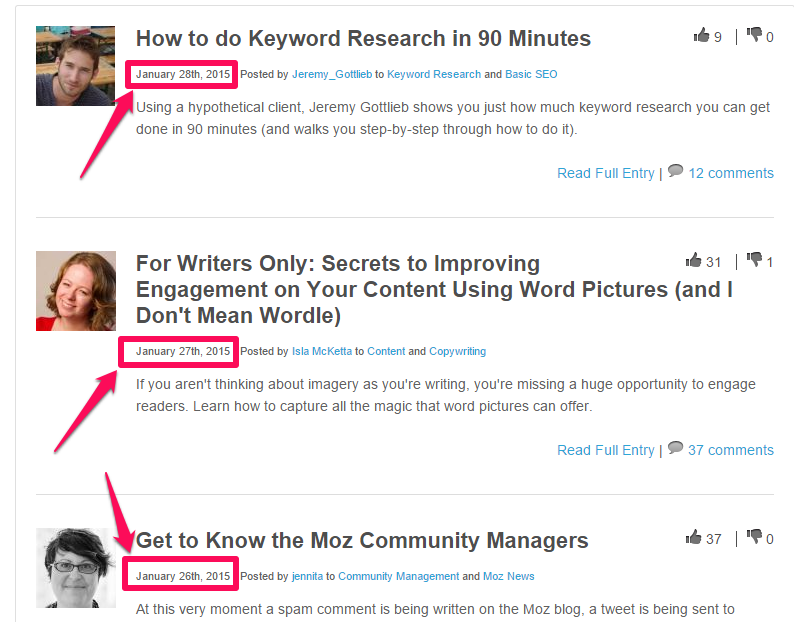

La mayoría de los sitios más populares publican nuevo contenido al menos una vez por semana y algunos, como Moz, lo hacen incluso a diario.

Para poder impulsar la puntuación que se da al contenido nuevo, algunas marcas populares como Mashable, publican distintos tipos de contenido detallado varias veces al día.

Conciencia de marca – Esto puede no ser obvio, pero los cambios en el algoritmo de Google apoyan un cambio hacia la construcción de marca.

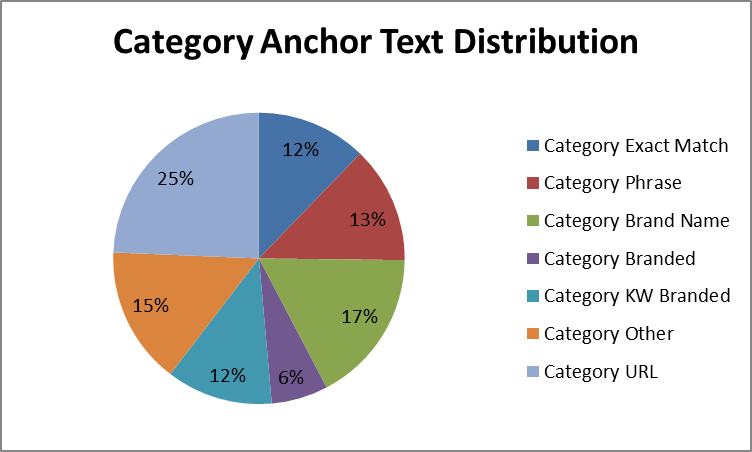

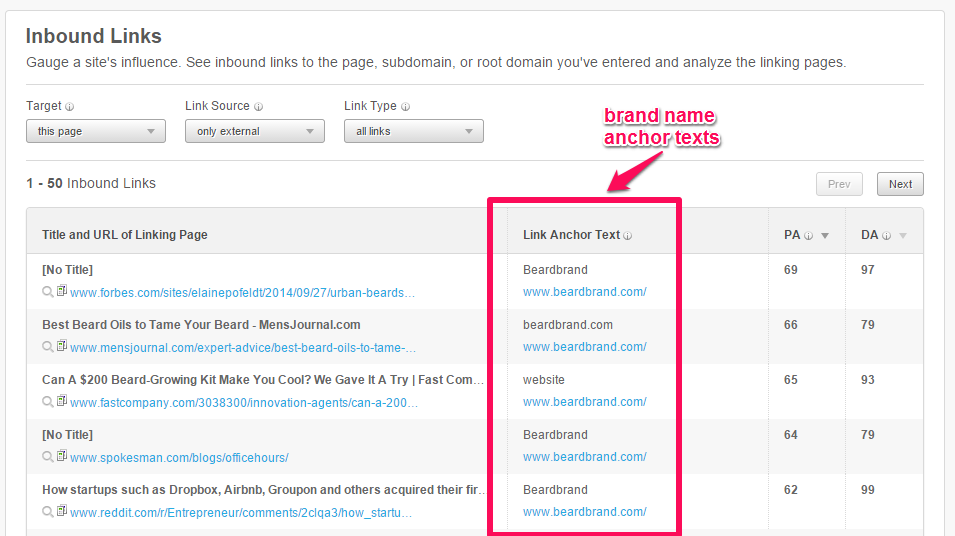

Antes de que Google empezara a penalizar sitios que usaran muchos textos de anclaje de palabras clave para enlaces internos, la sobreoptimización solía funcionar. Pero el SEO ha evolucionado y crear enlaces no debería ser el enfoque central (aunque es importante). Moz recomienda que el 17% de tus textos de anclaje tengan el nombre de la marca.

Las corporaciones, los dueños de pequeñas empresas y los blogueros se han vuelto meticulosos a la hora de usar textos de anclaje. Crea enlaces que impulsen tu marca y relevancia online y evita crear enlaces que ayuden artificialmente a mejorar tu posicionamiento orgánico.

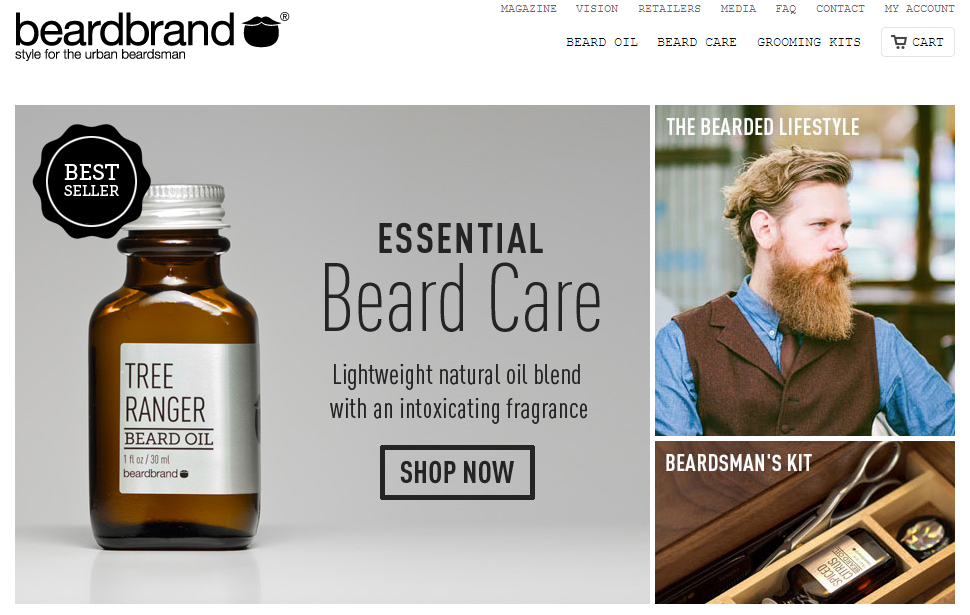

Mira por ejemplo BeardBrand.com. Su principal palabra clave (el mejor aceite para barba) está actualmente en el primer lugar de resultados de Google.

Muchos de sus textos de anclaje contienen nombres de marca y URLs de dominios. Este es el resultado que obtuve de OpenSiteExplorer:

Ahora veamos en más detalle las actualizaciones del algoritmo de Google…

Actualización ‘Panda’ del Algoritmo de Google

Seguramente has escuchado sobre Panda, pero a menos que seas un veterano experto en SEO que a diario lee noticias relacionadas con Google, es probable que no estés íntimamente familiarizado con los detalles.

La actualización Panda de Google revolucionó el SEO, haciendo que toda empresa que obtiene clientes potenciales y ventas por medio de Google, presten más atención al SEO.

Una importante lección que hemos aprendido es que el SEO nunca es el mismo. Está siempre evolucionando y las «buenas prácticas» de hoy, pueden estar desactualizadas mañana. Después de todo ¿quién hubiera pensado que dominios de concordancia exacta iban a ser un día penalizados por Google?

¿Qué es exactamente la actualización Panda? Panda fue nombrado así por el ingeniero, Biswanath Panda.

En febrero de 2011 se implementó el primer filtro de búsquedas que formaba precisamente parte de Panda. Es básicamente un filtro de la calidad del contenido, que se enfocaba en los sitios web de poca calidad y densidad de contenido, para prevenir que se posicionaran bien en las Páginas de Resultados de Motores de Búsquedas de Google (SERPs, Search Engine Result Pages).

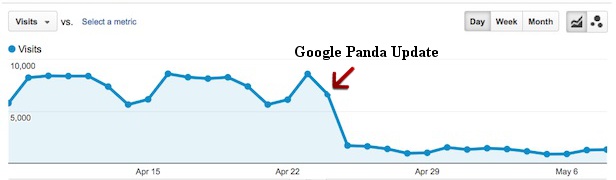

Cuando tenía lugar una importante actualización de Panda, los dueños de sitios notaban una caída de tráfico orgánico y posicionamiento, o una subida.

La actualización Panda del algoritmo de Google, cambió el SEO en el mundo. Cambió la estrategia de contenidos, de búsqueda de palabras clave y de objetivo. Incluso cambió la manera como se construyen los enlaces, dado que en últimas, los enlaces de calidad y con relevancia que apuntan a un sitio web, le añaden valor.

Google ahora podía determinar con mucha más precisión qué sitios eran «spam» (fraudulentos, no deseados o inútiles) y cuáles tendrían más probabilidad de ser considerados de utilidad por los usuarios.

Antes de Panda, el contenido de poca calidad podía posicionarse bien e incluso dominar los puestos más altos en las páginas de resultados de Google. La versión 1.0 de Panda se liberó para pelear contra las granjas de contenidos. Google dice que la actualización afectó el 12% de las búsquedas en Estados Unidos.

Nota: Panda es el nombre de una actualización porque su filtro trabaja periódicamente y cada vez que lo hace el algoritmo toma una nueva forma.

En otras palabras, el contenido de buena calidad seguramente aparecerá en los resultados de búsqueda, mientras que las páginas que escaparon de la anterior actualización, quedan atrapadas en la red de Panda.

Ha habido una actualización Panda cada 1 a 2 meses desde 2011, para un total de 26 actualizaciones desde el 14 de febrero de ese año. Este número puede no ser exacto, porque lo más seguro es que hayan ocurrido otras actualizaciones en medio, pero la cantidad cae en ese rango.

1) Actualización 1.0 de Panda: Este filtro de búsquedas apuntaba a las granjas de contenido – aquellos sitios que tienen muchos escritores que crean contenido de baja calidad con base en palabras clave específicas, en una apuesta por ocupar los primeros lugares en los resultados de búsqueda de Google. Esta actualización se enfocó primero en sitios web de los Estados Unidos y afectó al 12% de ellos.

Sin embargo, esto no significa que todos los sitios web con múltiples autores son spam o engañosos. Por ejemplo, Moz tiene cientos de escritores y sigue teniendo el placer de ocupar posiciones dominantes en Google porque se asegura de que el contenido sea de gran valor para sus lectores.

En otras palabras, el contenido que es bien investigado, detallado (in-depth) y se comparte en Facebook, Twitter, Pinterest, Google+ y otras plataformas sociales importantes, seguirán posicionándose bien – incluso mejor que antes.

2) Actualización 2.0 de Panda: Esta actualización, lanzada en abril de 2011, tenía como objetivo las búsquedas internacionales, aunque también impactó al 2% de las búsquedas en Estados Unidos.

Este filtro también afectó búsquedas internacionales en google.co.uk y google.com.au y búsquedas en inglés en países donde el inglés no es el idioma oficial, como por ejemplo google.fr, google.cn, cuando los usuarios eligieron resultados en inglés.

Amit Singhal, quien está a cargo de la calidad de las búsquedas en Google, le dijo a Vanessa Fox que Google «estaba enfocado en mostrar a los usuarios las páginas con mayor calidad y relevancia de la web».

3) Actualizaciones 2.1 – 2.4 de Panda: Hubo actualizaciones menores en mayo, junio y julio de 2011 (fechas aproximadas), en dónde Google incorporó más señales para ayudar a medir la calidad de un sitio.

Se penalizaron más páginas con contenido de poca calidad, mientras que aquellos que trabajaron duro en producir contenido interesante y rico en información, pudieron notar un incremento en su tráfico orgánico.

La actualización 2.3 de Panda fue pequeña y se enfocó en la experiencia del usuario. Los blogueros y propietarios de sitios web que escribieron y publicaron contenido que deleitó al usuario final y mejoraron la navegabilidad de la página, se vieron beneficiados por estos cambios.

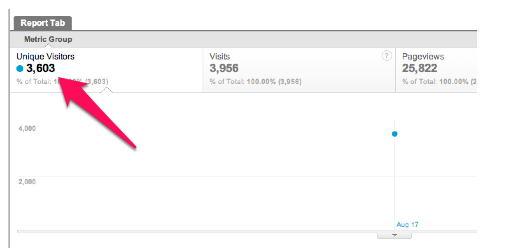

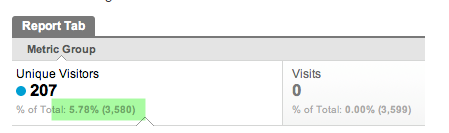

4) Panda 2.4: Esta actualización se lanzó el 12 de agosto de 2011 y afectó cerca del 6% a 9% de las búsquedas. Se centró en mejorar la tasa de conversión de los sitios web y su engagement, la capacidad de deleitar y retener un buen tiempo al usuario, según Michael Whitaker.

Antes de esta actualización, Michael Whitaker estaba obteniendo más de 3.000 visitas en su sitio web.

Tan pronto como la actualización 2.4 de Panda se lanzó, sus visitas mensuales bajaron a 207.

5) Panda 3.0: Este filtro de búsquedas empezó a salir el 17 de octubre de 2011 y fue anunciado oficialmente el 21 de octubre de 2011. Esta actualización subió de posición a sitios grandes en los SERPs – por ejemplo, FoxNews y Android.

Después de Panda 2.5, Google empezó a actualizar su algoritmo con más frecuencia. Esto se denomina “Panda Flux”.

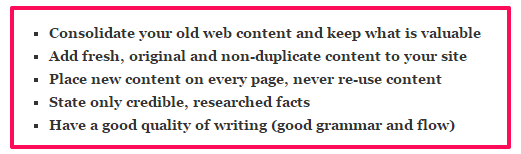

Para estar del lado seguro con tu contenido, Express Writers recomienda los siguientes pasos:

- Consolida el contenido de tu antigua página y conserva lo que es importante

- Añade contenido fresco, no duplicado

- Pon nuevo contenido en cada página, nunca reutilices contenido

- Solo habla de hechos creíbles y bien investigados

- Ten una escritura de calidad (buena gramática y fluidez)

6) Panda 3.1 sale al aire el 18 de noviembre de 2011. Fue un pequeño cambio que afectó al 1% de todas las búsquedas. Aunque esta cifra parece pequeña, aún sigue siendo significativa, teniendo en cuenta la cantidad de búsquedas que se realizan a diario.

Cada uno de estos cambios en el algoritmo de Google se dieron porque los usuarios no recibían información útil y relevante. Como una empresa de publicidad, Google quiere hacer dinero y, a menos que satisfaga a los usuarios, ¿cómo lo va a obtener?

7) Panda 4.0: El 20 de mayo de 2014, Matt Cutts publicó en su cuenta de Twitter que Google estaba lanzando Panda 4.0. Era la próxima generación de Panda y generó tanto ganadores como perdedores.

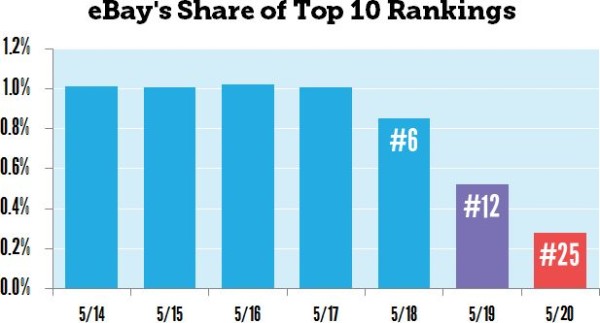

Esa actualización tuvo un gran impacto. Ebay perdió un significativo porcentaje de posicionamiento del top 10 en donde se encontraba.

Panda 4.0 se enfocó principalmente en grandes sitios web que habían estado dominando los primeros lugares para palabras clave de raíz o de base (seed keywords, en inglés).

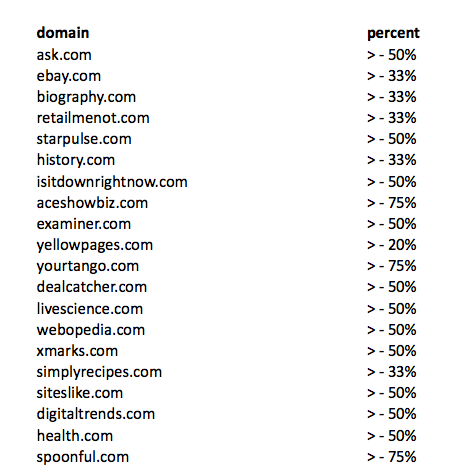

Cuando haces una página web hoy, tienes que escribir y publicar contenido detallado (in -depth) con mucha frecuencia. Este contenido tiene que proporcionar valor, ser interesante para el lector y resolver de manera definitiva un problema. Si no logra hacer eso, no llamará la atención de los usuarios y la tasa de conversión bajará. Los principales perdedores después de que Panda 4.0 saliera, fueron:

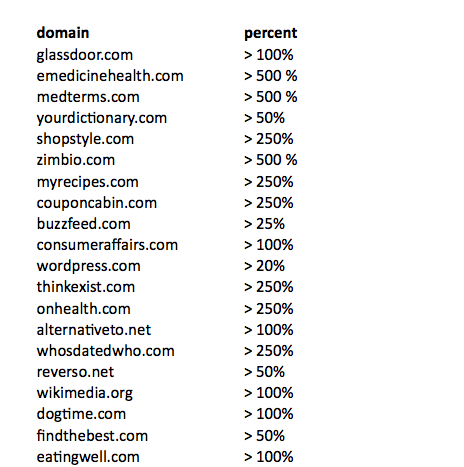

Como con toda actualización de Panda, también hubo ganadores. Aquí hay una lista hecha por Search Engine Land:

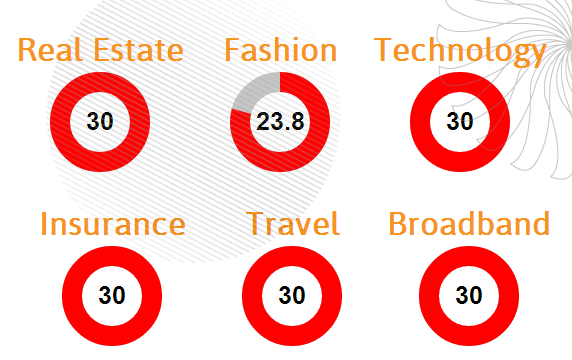

En general, no todos los sectores perdieron con Panda 4.0. Los más importantes a destacar son:

Factores que llevaron a una penalización de Panda (y qué hacer al respecto): Debido a que algunos sitios experimentaron un aumento en la clasificación orgánica y el tráfico, vale la pena preguntarse: ¿qué hace que un sitio sea vulnerable a un ataque de Panda? Aquí hay seis factores que pueden ser la causa, junto con sugerencias en cuanto a cómo solucionar el problema de fondo y volver a congraciarse con Google:

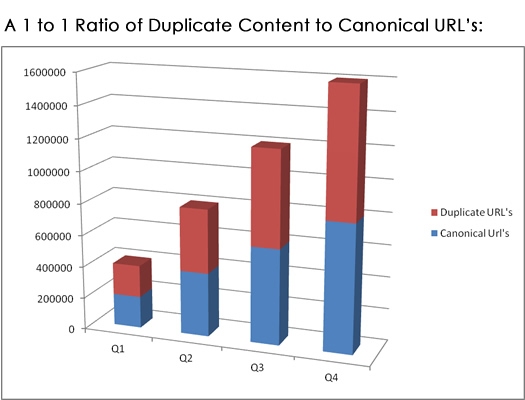

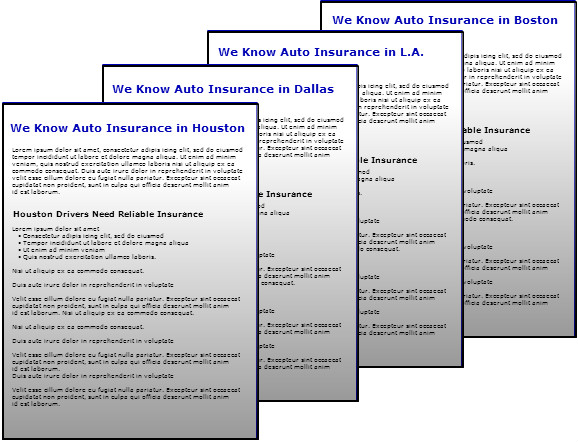

Contenido duplicado – ¿Tienes bastantes bloques de contenido que se repiten en tu sitio en varias páginas? Esto puede causar muchos problemas, sobre todo cuando se trata de SEO, y para los visitantes del sitio también representa un inconveniente.

En este video Matt Cutts explica que el contenido duplicado por sí mismo puede no afectar a tu sitio, excepto cuando se trata de spam.

No es aconsejable redireccionar páginas duplicadas. Cuando la spider de Google descubre contenido duplicado en tu sitio, primero analizará otros elementos que componen tu página web, antes de penalizarla.

Por lo tanto, se recomienda evitar por completo cualquier forma de duplicación de contenido y centrarse más bien en la publicación de contenido único, útil y detallado. No te engañes: no hay balance positivo entre el contenido original y el duplicado.

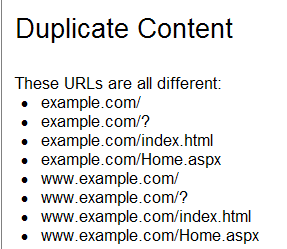

Cuando el mismo contenido aparezca a lo largo de tus dominios y direcciones URL, esto podría desencadenar un problema.

Hace algún tiempo, Greg Gothaus explicó por qué eso es un problema, compartió la imagen de abajo. Dado que el contenido es el mismo, aunque las direcciones URL son ligeramente diferentes, Google «piensa» que has duplicado el contenido.

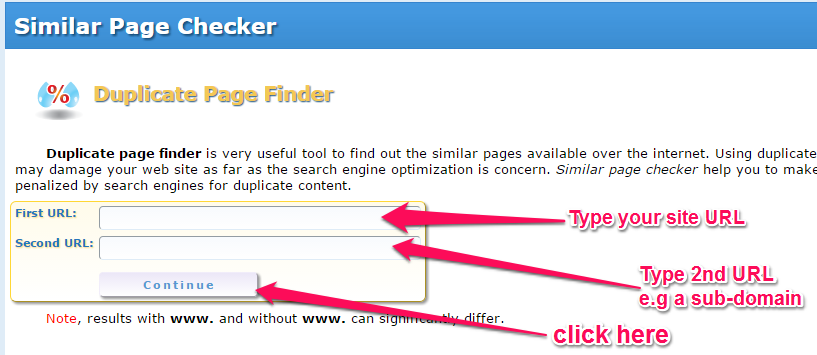

Afortunadamente, encontrar contenido duplicado en tu sitio o blog es bastante fácil de hacer. Solo tienes que seguir estos pasos:

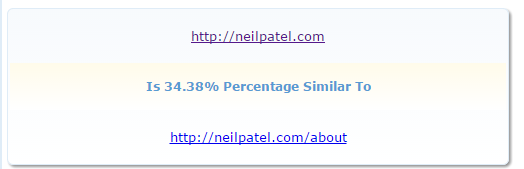

Paso # 1: Visita la herramienta de búsquedas de páginas duplicadas (Duplicate Page Finder en inglés). Introduce la URL de tu sitio. Introduce otra URL que desees comparar para encontrar contenido duplicado – por ejemplo, tusitio.com/acercade.

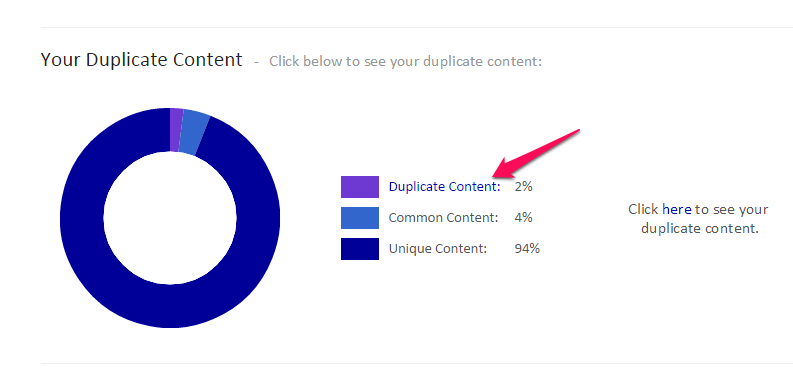

Paso # 2: Analiza los resultados. Si los resultados muestran que tus páginas contienen algo de contenido duplicado, a continuación puedes resolver el problema de una de dos maneras: o bien (1) revisar una de las páginas de manera que cada una contenga contenido 100% original, o (2) añadir una etiqueta de no-indexar de manera que la spider de Google la ignore y no la indexe ni le otorgue valor con otros enlaces.

Otro problema que puede causarte tropiezos es cuando tu contenido está duplicado en el sitio web de otra persona. Para encontrar contenido duplicado fuera de tu sitio, sigue estos pasos:

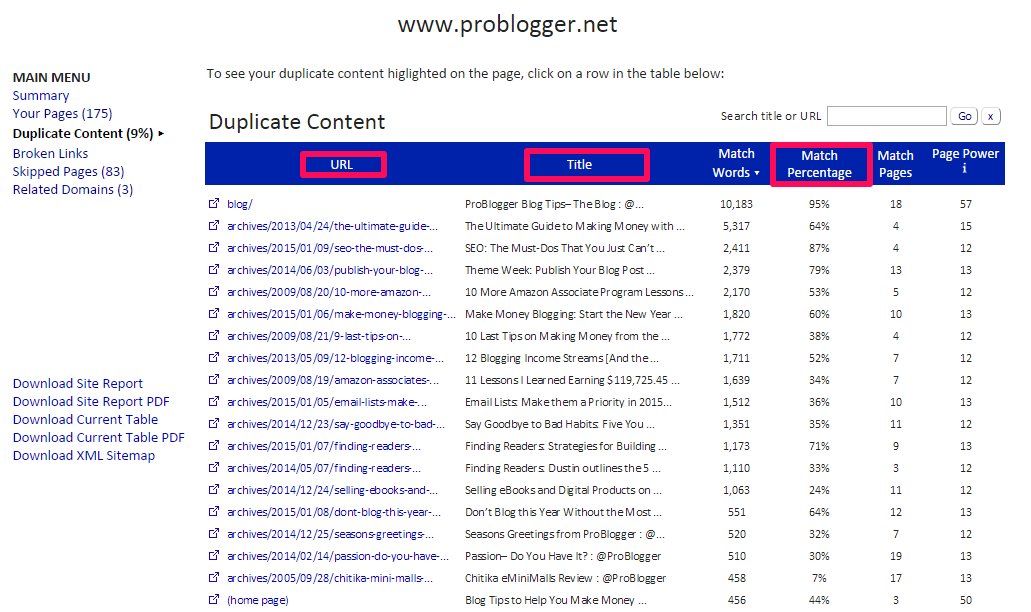

Paso # 1: Ve a Siteliner.com. Introduce la URL de tu sitio y haz clic en el botón «Go».

Paso # 2: Analiza páginas con contenido duplicado. En la página de resultados desplázate hacia abajo y encontrarás resultados para «contenido duplicado».

Una vez hayas hecho clic en el enlace «contenido duplicado», obtendrás una lista de todas las páginas que tendrás que hacer únicas y se te indicará en qué medida.

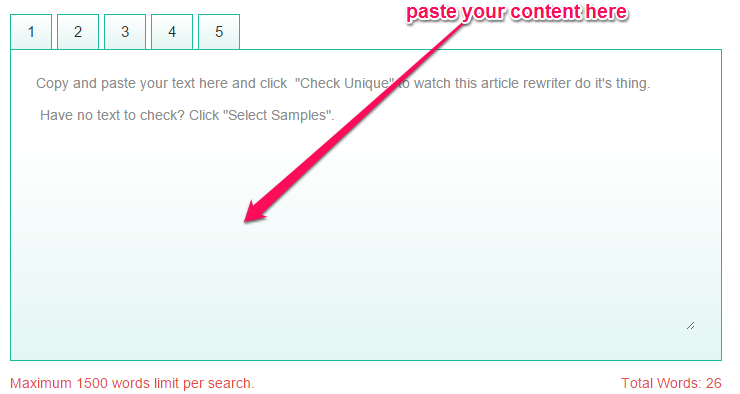

Si aceptas en tu blog publicaciones de autores invitados o artículos patrocinados, primero debes convertir en un hábito el comprobar si hay contenido duplicado. En el momento en que recibes el contenido, ejecuta rápidamente un análisis a través de cualquiera de las muchas herramientas disponibles en la web que verifican contenido plagiado – por ejemplo, smallseotools.com.

Después de pasar tu contenido por la herramienta, verás un análisis de fragmentos de frases y párrafos respecto a su autenticidad vs. si son duplicados.

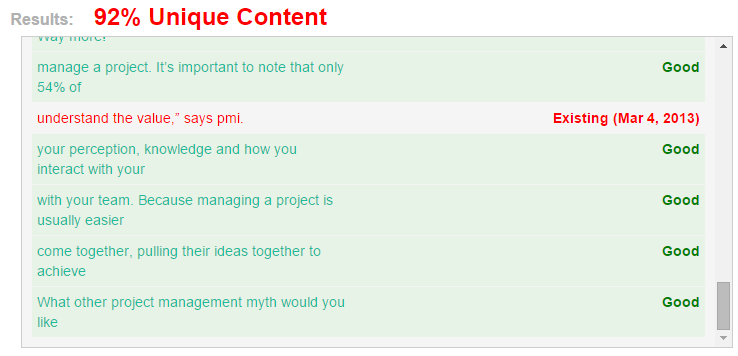

Nota: Mirando la captura de pantalla de arriba, vemos que los resultados especifican un 92% de autenticidad del contenido. Eso es un resultado bastante decente, con el cuál puedes vivir.

Sin embargo, si el fragmento de contenido que estás evaluando tiene puntuaciones entre el 10 al 70% de autenticidad, debes mejorarlo o retirarlo. El exceso de contenido duplicado puede dar lugar a una penalización de Google para tu sitio cuando se lleve a cabo la siguiente actualización de Panda.

También es muy importante tener en cuenta que solo porque tienes 100% de contenido auténtico en tu sitio, no significa que automáticamente tendrás una mejor posición en los resultados de búsqueda. Como señaló Frank Tankington con toda razón, «Si hay cinco artículos que son muy similares, sin importar qué artículo fue escrito primero, el que tiene más backlinks (vínculos externos, con enlaces que dirigen a otros sitios web) será el que ocupe el puesto más alto en los SERPs.»

Sin embargo, ya no se trata solo de tener la «mayor cantidad» de backlinks. En esta era post Penguin, se trata también de tener backlinks de confianza y que sean relevantes.

Enlaces entrantes (enlaces inbound) de baja calidad – Si has descubierto que tu SEO se está estancando y estás seguro de que el contenido del sitio es útil y auténtico, el siguiente paso es auditar tus enlaces entrantes.

Según Kristi Hines, el contenido publicado en el pasado que no sea de buena calidad, te puede salir caro en el futuro. Así que no es suficiente con empezar hoy a construir buenos enlaces de gran calidad. Los que creaste cuando empezaste en el marketing pueden tener un efecto en tu posicionamiento en el presente.

La horrible verdad es: Si tu sitio web tiene una gran cantidad de enlaces entrantes provenientes de sitios irrelevantes (por ejemplo granjas de contenidos o simplemente sitios de otros tipos de mercados) tus probabilidades de recibir una penalización de Google aumentan.

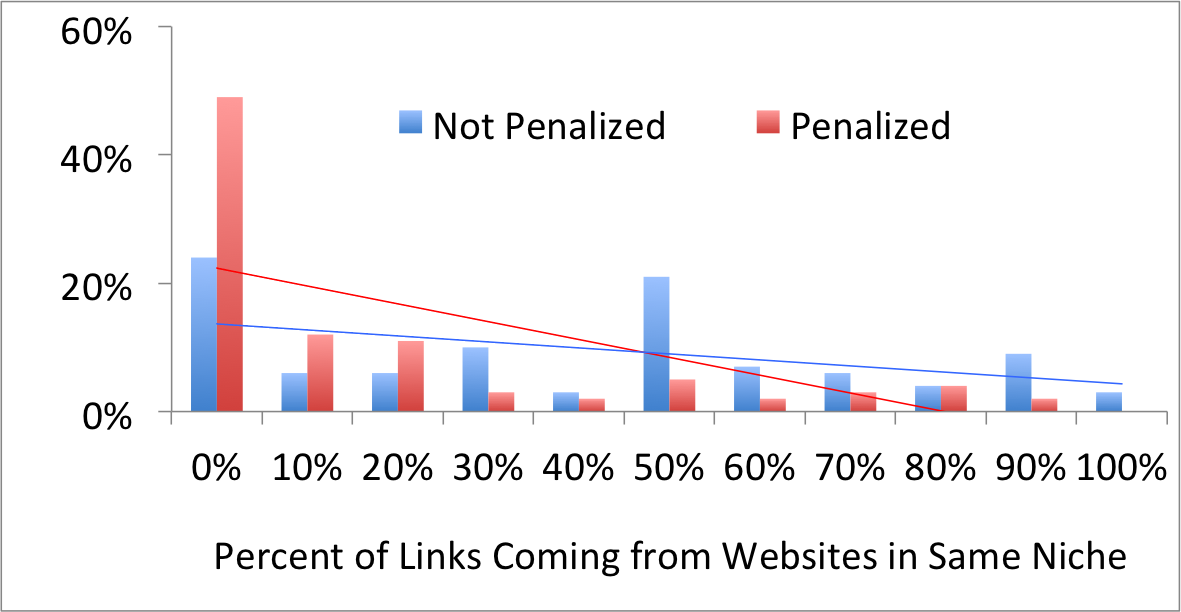

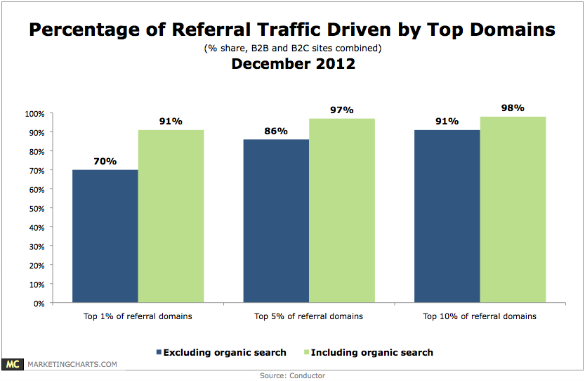

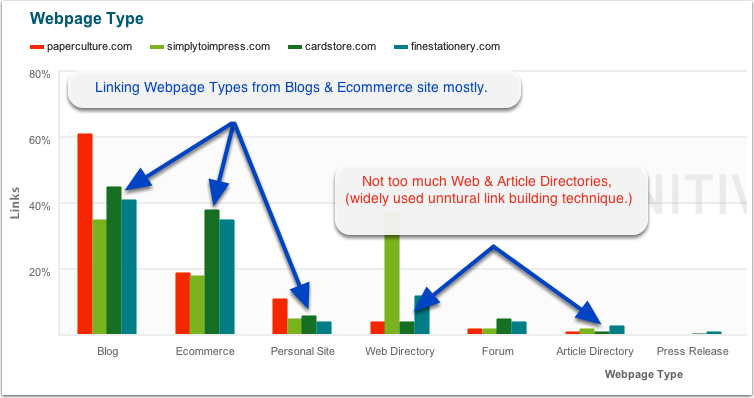

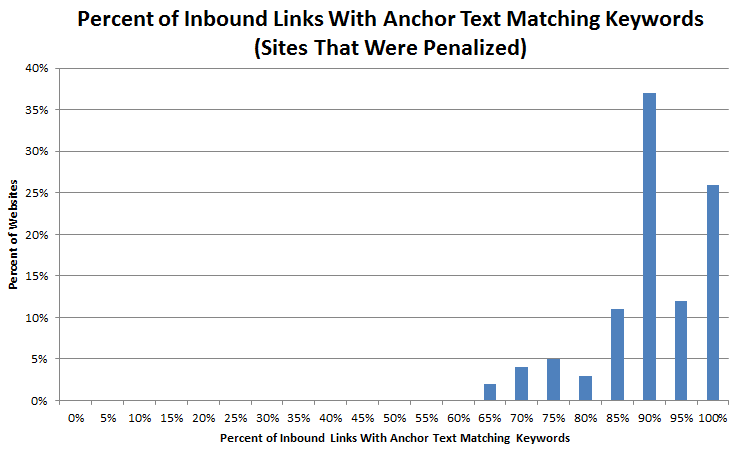

En esta era de la actualización Penguin de Google, necesitas enfocarte en obtener enlaces entrantes predominantemente de sitios que hablan del mismo tema que tú. El gráfico de The SEM Blog a continuación, nos da una imagen más clara:

Pero antes de que puedas hacer cualquier cosa respecto a esos enlaces de baja calidad, primero necesitas encontrarlos. En otras palabras, debes averiguar cuántos backlinks has creado o ganado en tu sitio web desde que lo creaste. Afortunadamente, esto es más o menos simple. Solo sigue estos pasos:

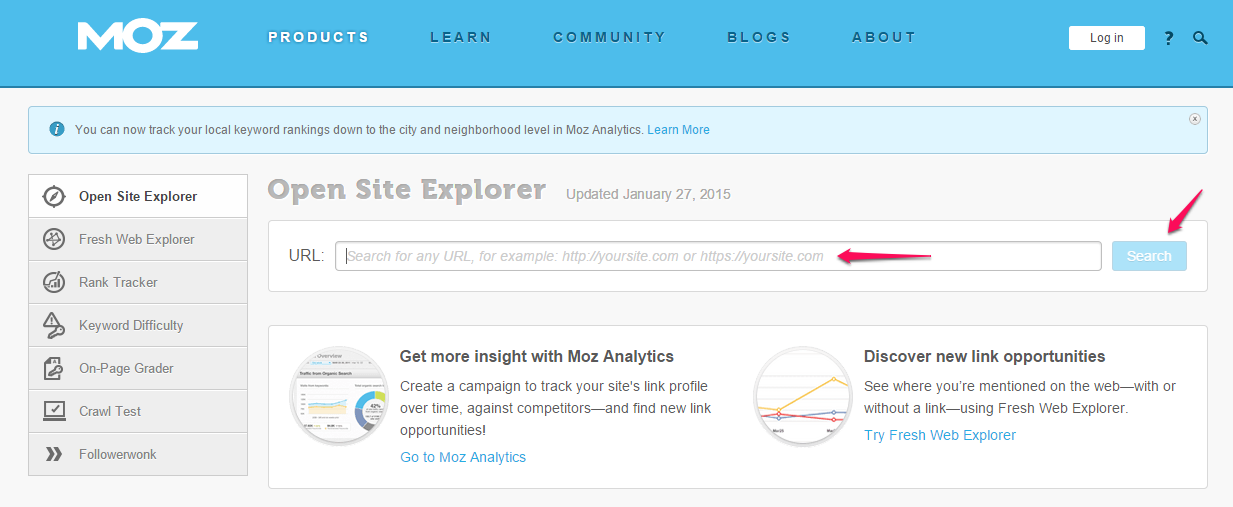

Paso #1: Ve a OpenSiteExplorer. Escribe la URL de tu sitio. Y haz clic en el botón «search».

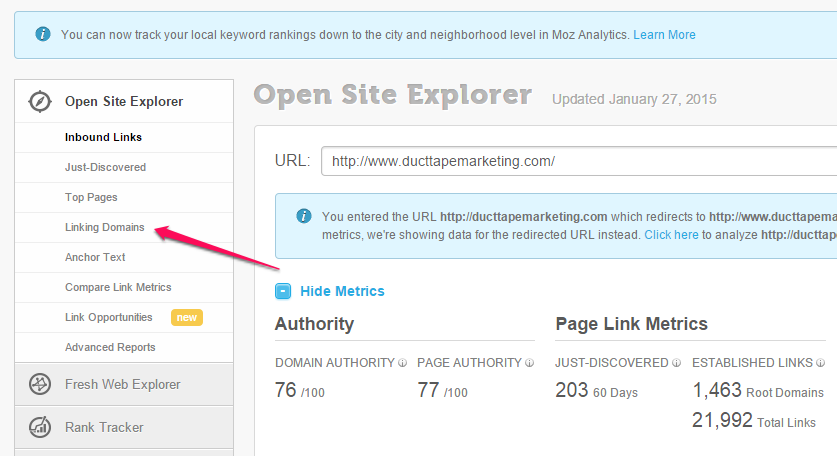

Paso #2: Haz clic en “Linking Domains».

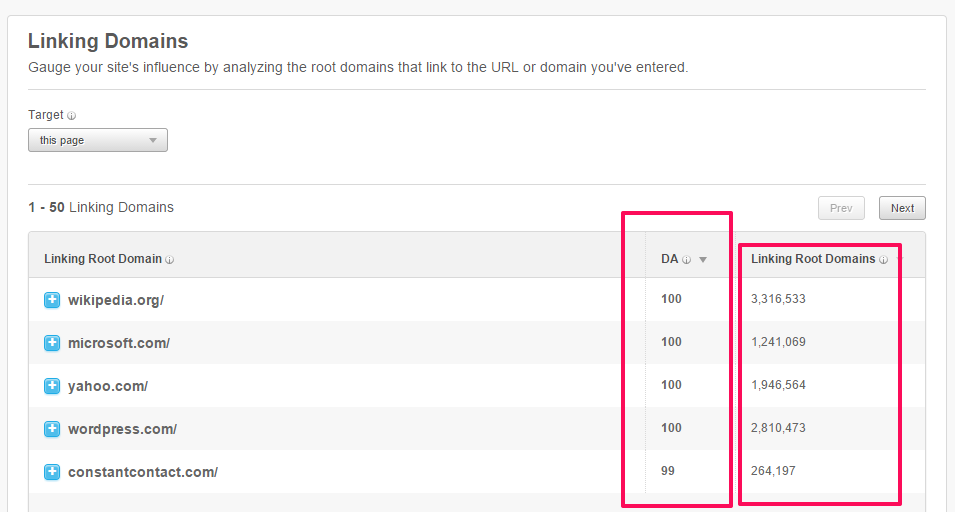

Paso #3: Analiza los dominios enlazados.

Puedes encontrar enlaces tóxicos en tu propio sitio web en distintos lugares. Enlaces en tu pie de página, enlaces site wide (aquellos enlaces que se encuentran en todas las páginas de tu sitio web, como en las barras laterales por ejemplo) y los enlaces sobreoptimizados con textos de anclaje (anchor texts), entre otros, esto es un buen lugar para empezar.

Si necesitas más información sobre cómo arreglar alguno de esos dos factores de penalización de Panda – contenido duplicado o enlaces entrantes de baja calidad – estos artículos te pueden ayudar:

- Cómo Identificar y Resolver Problemas de Contenido Duplicado en tu Sitio Web

- Cómo Encontrar Enlaces de Baja Calidad con Buzzstream

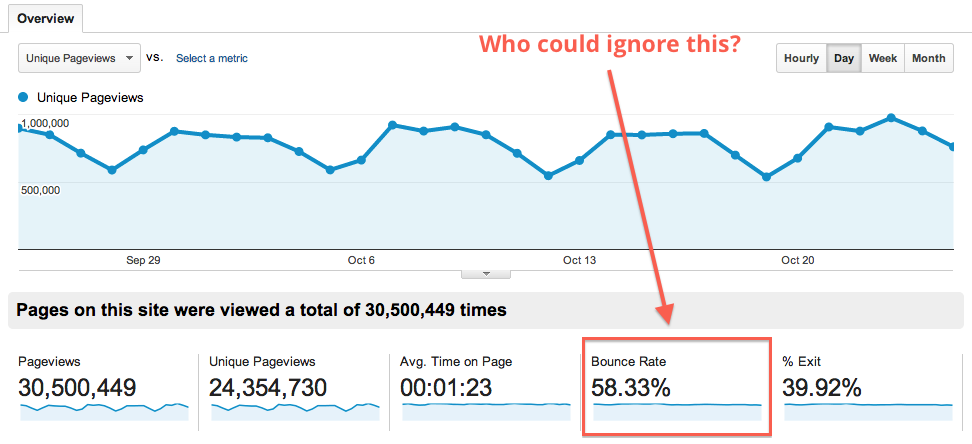

Tasa alta de rebote – El término «tasa de rebote» se refiere simplemente a la cantidad de sesiones que su sitio web recibe por página. Una sesión por página es cuando alguien visita una página en tu sitio web y de repente la abandona, sin interactuar más en tu sitio (hacer clic en otros enlaces o leer más contenido).

La tasa alta de rebote puede ser una señal para Google de que quienes visitan tu sitio web, no encuentran lo que buscan, o no consideran que tu sitio sea de grandísima ayuda.

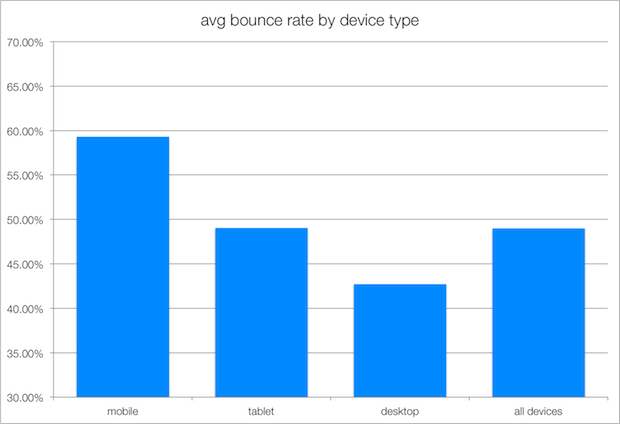

¿Qué sería una tasa de rebote aceptable o dentro de la media? La respuesta varía de acuerdo a tu industria. Lo que realmente importa es que tus tasas de conversión aumenten. Esta es la media de tasa de rebote por plataforma.

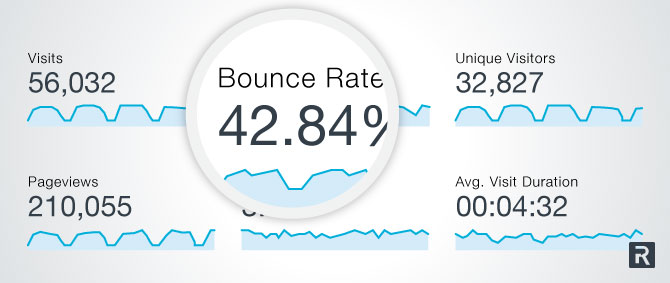

Es absolutamente posible reducir esa tasa de rebote y por lo tanto revertir esa tendencia. Por ejemplo, Recruiting.com redujo su tasa de rebote a un 42.84%.

Como regla general, si tu tasa de rebote está sobre el 60%, entonces probablemente quieras trabajar para reducir ese número. Una tasa de rebote menor a eso estaría bien. ¿Cómo se compara con la tuya?

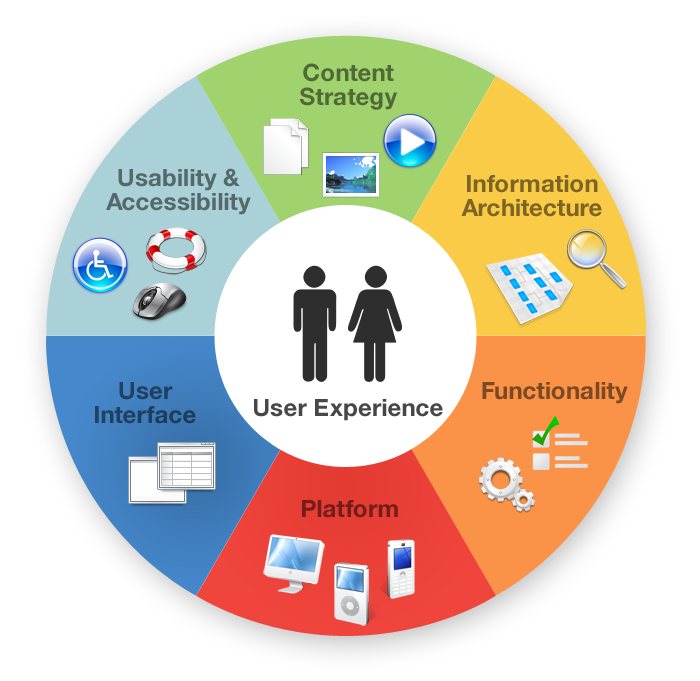

Diseño web y usabilidad son los factores básicos que afectan tu tasa de rebote. Recuerda, si los usuarios no pueden encontrar fácilmente lo que están buscando en tu sitio, Google asume que tu contenido no es útil. Esto es así porque la spider literalmente sigue a las personas.

Cuando despiertas interés en los lectores de tu blog (engagement), ellos a su vez se interesan en tu sitio web, lo que a su vez reduce la tasa de rebote y le da a tu sitio una mejor calificación para posicionarse más arriba en Google.

Las tasas de rebote pueden fluctuar significativamente en el tiempo – y una tasa de rebote que sube un poco no necesariamente siempre es algo malo. Puede ser causado por algún ajuste importante realizado a tu sitio web, Por ejemplo, cuando rediseñas tu blog, tu tasa de rebote seguramente subirá un poco temporalmente mientras que los usuarios se acostumbran al nuevo aspecto.

Baja repetición de visitas – Si los usuarios de tu sitio web vienen una vez para nunca volver, Google puede «pensar» que tu sitio no es relevante ni útil.

De modo que es una buena idea prestar atención a las estadística de la gente que vuelve a visitar. Una vez que entras a tu cuenta de Google Analytics, localiza estas métricas y luego compara con los meses anteriores.

Para ajustar una cifra baja de repetición de visitas, premia a los visitantes cuando regresen a tu sitio después de una visita inicial. Puedes hacer esto ofreciendo un contenido útil, como un informe valioso sin coste, o con regalos como acceso a un evento o curso virtual. Adicionalmente, busca maneras de mejorar la experiencia de quien vuelve a visitar tu sitio web y aumentar su nivel de satisfacción cuando regresa a por más.

Como ejemplo, Amazon tiene una de las más altas tasas de gente que vuelve entre los sitios de compras. Cuando un usuario llega a Amazon por primera vez y busca, o explora diferentes productos, Amazon automáticamente rastreará sus movimientos. Cuando el usuario regresa, Amazon le muestra los mismos productos o productos similares.

Amazon también hace un uso excelente de la estrategia de upsell (venta adicional) para persuadir a las personas a comprar sus productos. Esto les facilita a los compradores encontrar lo que quieren comprar y los anima a ordenar rápido.

Si tu sitio no retiene visitas y no las hace volver otra vez, esto podría afectar negativamente tu calificación en Google.

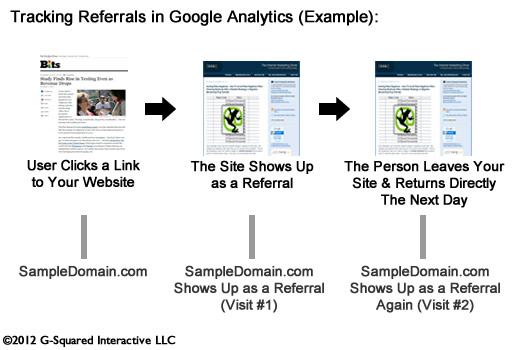

En tu cuenta de Google Analytics debes también prestar atención a las fuentes de tu tráfico, de dónde provienen. Algunos dominios pueden estar enviándote visitas y varios de esos pueden ser los que te envían las visitas que vuelven.

Concéntrate en la retención. Fuentes que refieren visitas orgánicas tienden a ser más confiables en este asunto que las de redes sociales.

Better Biz hizo un estudio de tres meses tanto para B2B (negocio a negocio) como B2C (negocio a consumidores) para determinar las mejores fuentes de tráfico web segmentado. Esto es lo que encontraron:

¿Cómo puedes conseguir que más personas regresen a tu sitio web? Estas son unas sencillas maneras de lograrlo:

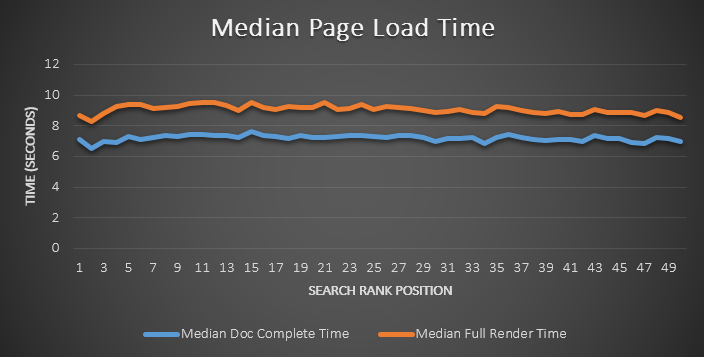

a). Reduce el tiempo de carga de tu sitio – Si quieres atrapar más visitas recurrentes, revisa si puedes aumentar la velocidad de tu sitio web. Según Moz, «la velocidad de un sitio web realmente afecta al posicionamiento web». Haz que tu sitio cargue más rápido y tus visitas estarán más tiempo (y habrá más probabilidad de que regresen en el futuro).

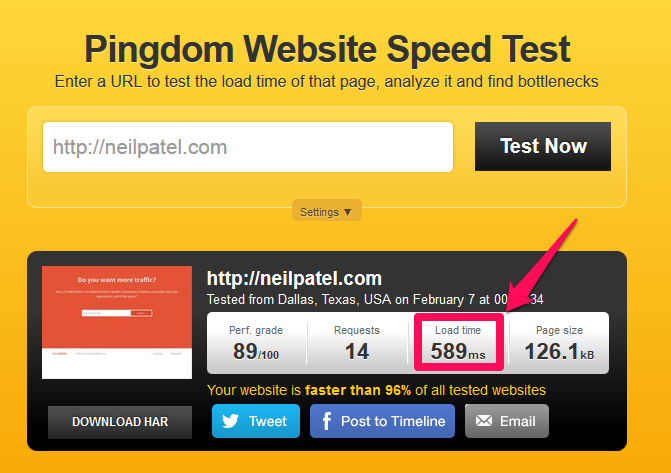

Aunque el impacto directo en el posicionamiento no sea tan significativo, como puedes ver abajo, sin embargo es cierto que los sitios que cargan rápido tienen una mejor experiencia de usuario y por lo tanto, mejora la percepción de la página.

He aquí una estadística importante: 40% de las personas abandonan una página web que tarda más de 3 segundo en cargar. Así que una página que carga lento puede resultar en altas tasas de rebote, así como también en una tasa menor de gente que vuelve a visitar.

Cuando descubrí que tanto Google como mis lectores prefieren los sitios que cargan muy rápido, me adentré en el tema. Mis esfuerzos resultaron en llevar mi sitio de cargar en 1.9 segundos a 1.21 segundos. A cambio, esto incrementó el tráfico directo a mi blog en más de 2.000 visitas por día.

Aquí está mi tiempo inicial de carga, antes de la optimización:

Y aquí está el resultado, después de que el equipo de StudioPress modificara mi código:

Empieza a mejorar el tiempo de carga de tu sitio web hoy mismo. Puedes seguir esta guía paso a paso.

b). Sé útil – Una de las cinco maneras de obtener visitas recurrentes es ayudando a las personas, ofreciéndoles contenido útil. Tu contenido debe ser capaz de resolver un problema de manera definitiva. Por ejemplo, podrías escribir un tutorial paso a paso sobre un tema relevante para tu industria.

Si por ejemplo con frecuencia escribes sobre SEO o marketing por Internet, podrías proveer una Guía detallada sobre Google Analytics acompañada con capturas de pantalla para explicarlo mejor. Esta guía sería un buen ejemplo de un contenido creado para resolver un problema, teniendo en cuenta que muchas personas tienen dificultades para entender Google Analytics.

Porcentaje alto de contenido repetitivo – El contenido reutilizado (boilerplate en inglés) se refiere al contenido de tu sitio web que vuelve a usarse en varias partes del mismo. Por ejemplo, un párrafo en particular que haya sido de gran utilidad, puede ser reutilizado en otros artículos de tu sitio web. Uno o dos párrafos así no causarán mayor daño, pero si el porcentaje general de contenido repetitivo sube mucho, tu sitio podría bajar de posición.

Como regla general, evita usar el mismo contenido o contenido muy similar en más de una página de tu sitio web. Concéntrate en contenido único y auténtico – esa es la mejor manera de mejorar tu posicionamiento.

Un tipo de contenido reutilizado que ocurre con frecuencia es el «contenido escondido». Cuando le muestras cierta página a los usuarios y Google inspecciona otras páginas también, el motor de búsqueda toma esto como contenido repetido. Si eso pasa muchas veces, tu sitio podría verse penalizado.

Meta etiquetas irrelevantes – Es muy importante configurar con precisión las meta etiquetas ya que las meta etiquetas irrelevantes aumentan las posibilidades de que tu sitio sea penalizado por Google. Aquí puedes ver cómo agregar meta etiquetas relevantes a las página de tus sitio web.

Recuerda, las meta etiquetas consisten en el título, la descripción y las palabras clave.

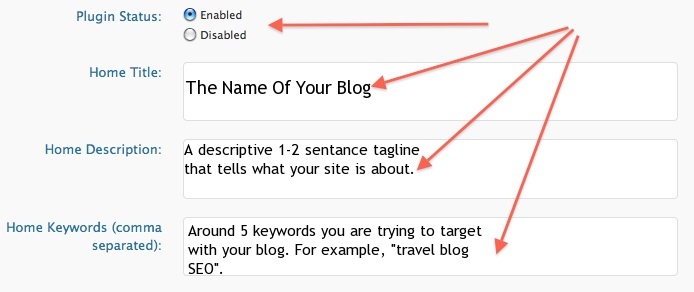

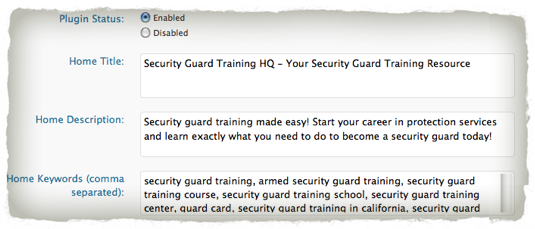

Si has instalado el plugin SEO Todo en Uno, encontrarás que es fácil configurar tus meta etiquetas en tres minutos o menos. Recuerda que al Panda de Google no le agradan las páginas duplicadas. Travel Blog Advice muestra lo simple que es instalar el plugin.

En la siguiente imagen, podrás ver cómo las meta etiquetas de Pat Flynn son específicas y relevantes para la página en cuestión. Sin embargo, en las prácticas modernas de SEO, no es aconsejable tener muchas palabras clave, aún si estas son relevantes.

Nota: Evita el uso excesivo de términos clave, conocido en inglés como keyword stuffing. Según David Amerland, esto puede conducir a penalizaciones de tu sitio web cuando se llevan a cabo actualizaciones de Panda.

Cómo recuperarse de un golpe de Panda – ¿Cómo identificas un golpe de Panda y cómo recuperas tu sitio web de su penalización? Si tu sitio web o blog fue golpeado por una actualización Panda, el siguiente paso es crear un plan para solucionar el problema. Esto puede ser difícil ya que hay muchos artículos y publicaciones online que discuten sobre la teoría tras las penalizaciones de Google, pero que realmente no proveen pasos concretos para solucionar el problema.

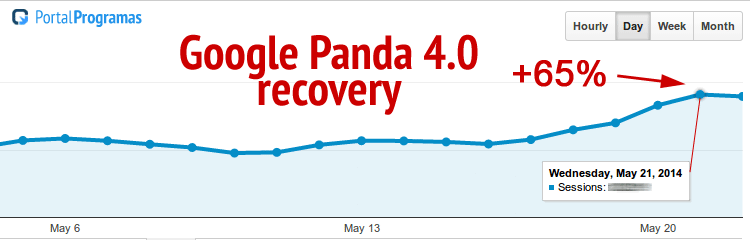

Tomando acción al respecto, el sitio Portal Programas recuperó 65% de su tráfico web tras una actualización Panda. Y lo hicieron simplemente siguiendo un plan sencillo enfocado en la experiencia de usuario.

Si ves una reducción en el tráfico orgánico y posicionamiento tras una actualización Panda, puedes estar seguro que has recibido una penalización de Google.

En cuanto a Panda, lo que debes hacer es evitar mostrar a las personas contenido de poca densidad, o corto. O conviertes ese contenido corto en uno extenso y más detallado, o lo mejor que puedes hacer es retirarlo del todo, especialmente aquellos que tienen de 10 a 100 palabras.

Re-escribir tu contenido es otra manera simple de remover una penalización de tu sitio y así transformarlo en un sitio de buena calidad a los ojos de Google. Eric Enge, el Presidente de Stone Temple Consulting, le dijo a Search Engine Watch que uno de sus clientes tuvo un 700% de recuperación re-escribiendo y agregando contenido a su sitio.

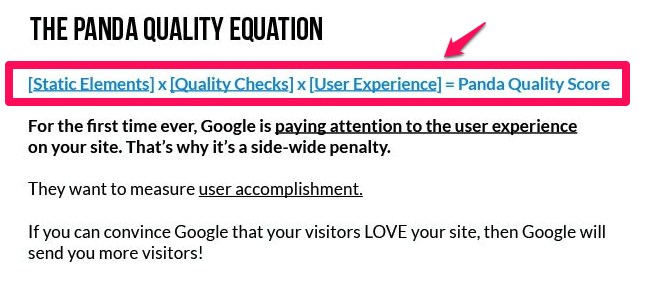

Mejora la Calificación de Calidad Panda – Además de retirar las páginas con contenido pobre, o agregar más contenido para volverlas más detalladas y útiles, deberías también prestar atención a la Calificación de calidad de Panda.

Sigue esta ecuación de calificación de Panda para obtener una puntuación más alta:

- Elementos Estáticos

- Chequeos de Calidad

- Experiencia del Usuario

La anterior ecuación es del mismo Google, así que podemos confiar en que nos ayudará a recuperarnos de una penalización de Panda. Exploremos cada uno de esos elementos:

1) Elementos Estáticos – Todo sitio web debería tener elementos o páginas estáticas que dicen lo que el sitio hace, quién está detrás de este y las condiciones de servicio que apliquen. Los elementos estáticos son usualmente: Política de Privacidad, Contacto, Quienes Somos y Condiciones y Restricciones.

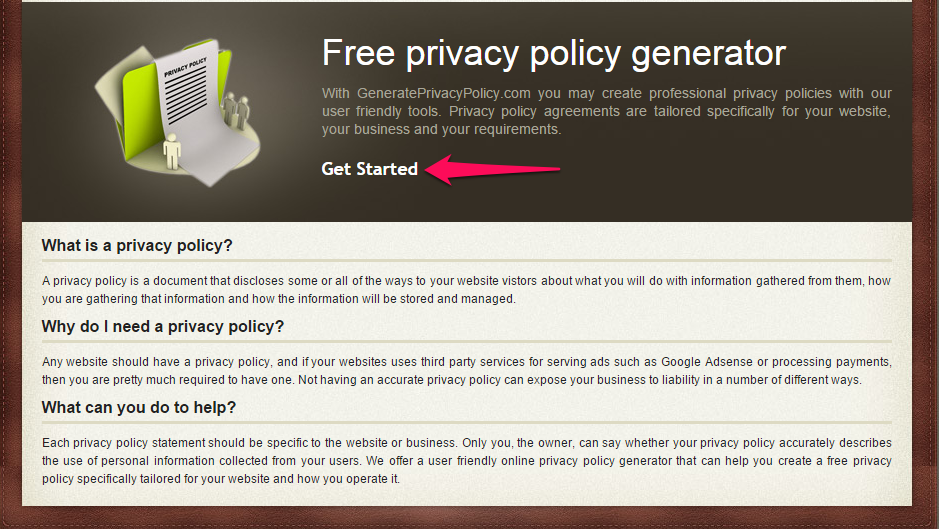

i). Política de Privacidad – La mayoría de contenido de la sección de Política de Privacidad, es generada con herramientas de terceros. Puedes agregar a esta página una etiqueta de no-index o no-follow en la sección HTML <head>.

Aun así, Google prefiere que esta página también sea única. Evita copiar y pegar contenido de otras fuentes ya que Google lo considerará como contenido duplicado.

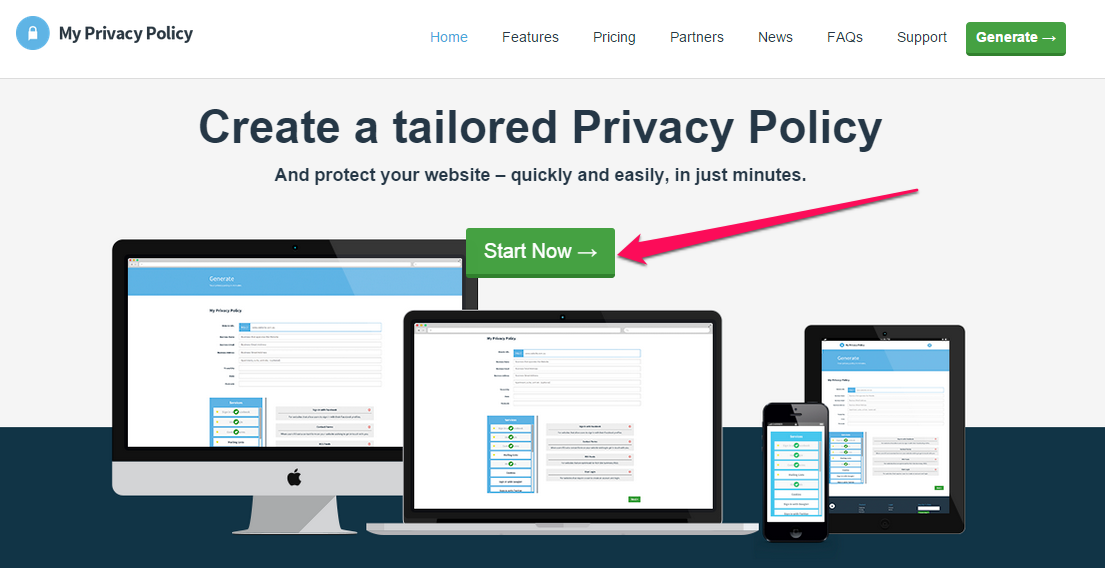

Si usas una herramienta de terceros, entonces personaliza y reescribe el contenido. Después de generar el contenido de tu sección de política de privacidad, puedes reescribirlo. Una buena herramienta premium (pagada) que puedes tener en cuenta es MyPrivacyPolicy.

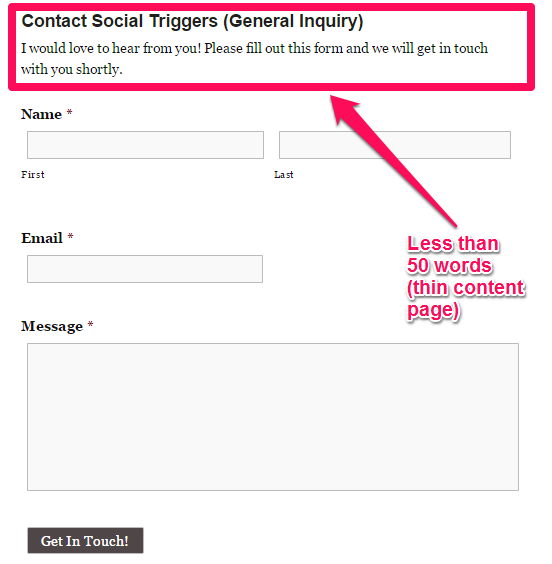

ii). Contacto – Otro elemento estático de tu sitio web es la página de «contacto». Es usualmente corta, con menos de 100 palabras.

Es importante que uses la etiqueta no-index en esta página o que agregues información debajo del formulario de contacto o dirección ya que el bot de Google inspecciona y almacena direcciones de casas y oficinas, correos electrónicos, autores, números de contacto, etc.

Nota: Google ha dejado muy claro que «si solo una o dos páginas de tu sitio web son de buena calidad mientras que todas las demás no lo son, entonces Google determinará que todo tu sitio web es de poca calidad».

Cada página cuenta, así que procura hacer de tus elementos estáticos (página de contacto, páginas de quienes somos, etc.) deben ser ricos, únicos y útiles.

iii). Quienes Somos – Tu “Página ‘Quienes Somos’” es otro importante elemento estático que puede aumentar o reducir tu calificación de calidad de Panda. ¿Sabes Cómo Escribir la Página ‘Quienes Somos’ de manera Perfecta?

En resumen, querrás escribir contenido valioso y único en esta páginas, así como con todas las otras. Cuenta una historia que cautive a tu audiencia y provea un clara llamada a la acción (CTA).

Una página de «Quienes Somos» con solo unas pocas oraciones puede llevar a que Google asuma que todo tu sitio es de baja calidad. Aprovecha la oportunidad para actualizar tu página – después de todo, es tu historia, tu experiencia, tus pérdidas y ganancias.

iv). Términos y Condiciones – Aunque la mayoría de visitas al sitio web no hacen clic en esa página para leer su contenido, es importante que lo hagas único y acorde a Google. Si eres un bloguero, hacer esta página para tu blog es opcional. Sin embargo, si tu sitio es de ecommerce o vende servicios, asegúrate de tener esta página y que esté bien hecha.

Las mismas reglas que usaste para crear la página «política de privacidad» aplican también aquí. Trata de crear una página de «términos y condiciones» auténtica. Asegúrate que sea detallada, in-depth, (700 a 1000 palabras) y trata tanto como sea posible de que sea interesante de leer.

2) Verificación de Calidad – En la Ecuación de Calidad de Panda que consideramos antes, uno de los factores que pueden ayudar a recuperar tu sitio de una penalización Panda, es una sólida Verificación de Calidad. En otras palabras, el código del sitio tiene que ser excelente y seguir los últimos estándares.

Etiquetas HTML que no coinciden, errores de PHP, Javascripts dañados y reglas de CSS inapropiadas, pueden todos resultar en una pobre experiencia para el usuario. Sabemos que Google valora una buena experiencia de usuario, porque ayuda a Google a medir el grado de interés y conexión (engagement) que proporciona a los usuarios.

Si tu sitio fue construido usando antiguas versiones de HTML, considera actualizar tu sitio usando HTML5. Asegúrate que tu meta descripción y etiquetas de título sean únicas y contengan los términos clave relevantes que tienes por objetivo.

3) Experiencia de usuario – Dado que Google Panda es un penalización del site-wide que califica tu sitio entero, asegúrate de mejorar la experiencia del usuario en todo tu sitio web. Cuando mejoras la experiencia del usuario, te recuperas de un golpe de Panda.

Cuando hagas el mapa de la experiencia de usuario, asegúrate de que se cumplan todos estos factores:

i) ¿Provees alguno de los puntos de experiencia de usuario? Si vendes un producto o servicio, ¿cómo lo reciben tus visitas o clientes potenciales?

ii) ¿Resuelve tu contenido algún tipo de problema? Tus usuarios mostrarán lo satisfechos que están a través de su interacción con el contenido. ¿Se quedan a leer? ¿Dejan comentarios en tus publicaciones?

iii) ¿Puedes mejorar la navegación? Si los usuarios no pueden navegar con facilidad para ir a tu página de inicio desde cualquier parte de tu sitio web, entonces hay trabajo por hacer. Aprende de sitios con excelente navegación – un buen ejemplo es Mindtools.com.

En el momento en que mejoras la navegación en tu sitio web, mejorarán también tu tráfico y tu posicionamiento orgánico. Haz que sea fácil hacer clic en todos los enlaces de navegación y asegúrate de que tu buscador interno funcione perfectamente.

iv) ¿Regresan a tu sitio los usuarios? Como ya discutimos, Google no solo se interesa por las visitas actuales que recibas, sino también por los que regresan.

Cuando tu contenido es muy bueno, las personas vendrán por más. Pero si no lo es, rebotarán, resultando en una baja puntuación de calidad.

v). ¿Con qué velocidad carga tu página? Si tu sitio carga en menos de 4 segundos, entonces no tienes problema. Pero si no, tienes cosas por mejorar. Busca maneras de lograr que tu sitio cargue más rápido por medio de realizar optimizaciones al mismo.

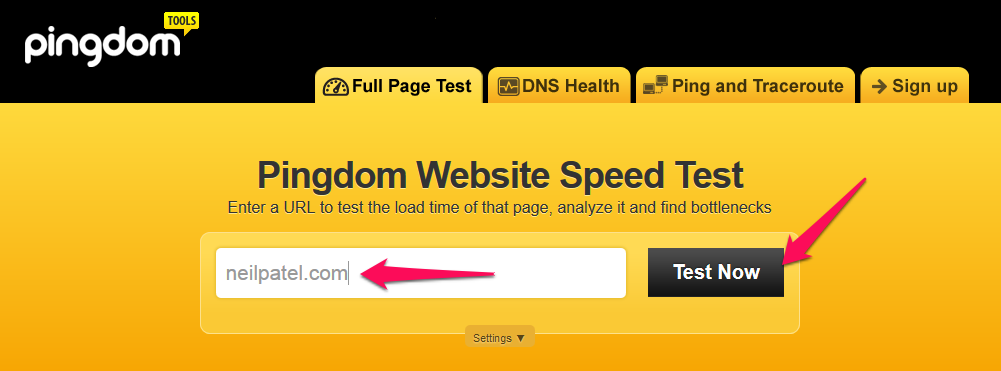

¿Cómo sabes la velocidad de carga de tu sitio?

Paso #1: Ve a tools.pingdom.com. Introduce la URL de tu sitio y haz clic en el botón «Test Now».

Paso #2: Verifica la velocidad de tu sitio.

Actualización ‘Penguin’ del algoritmo de Google

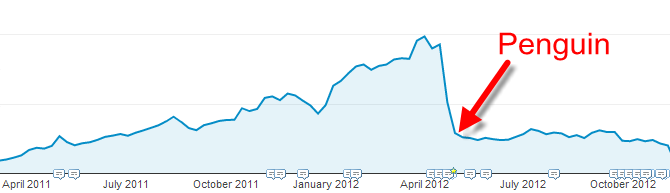

El 14 de abril de 2014, Google lanzó la primera actualización Penguin. Mientras que la actualización Panda se enfocaba principalmente en contenido de poca calidad y densidad, el Pingüino de Google es un set de mejoras al algoritmo, que presta más atención a los enlaces entrantes.

Antes del lanzamiento de Penguin, los propietarios de sitios web, los marketers de contenidos y los webmasters, todos empleaban diferentes tácticas para la construcción de enlaces.

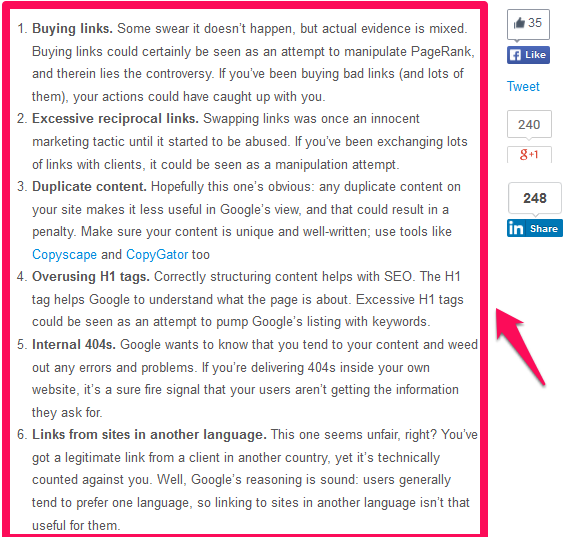

Algunas de esas tácticas funcionan todavía pero, la mayoría de las estrategias de construcción de enlaces ya han muerto. Según Rival IQ, hay cuatro factores que llevarán a tu sitio a recibir una penalización del Pingüino de Google. Son los cuatro que están en esta imagen y que se explican a continuación:

i). Esquema de enlaces (Link schemes) – Los enlaces siguen siendo importantes, pero los sitios de buena calidad son la mejor manera de mejorar el posicionamiento en los resultado de búsquedas.

Los esquemas de enlaces son esos tipos de actividades orientadas a crear enlaces que manipulan o inducen a los motores de búsquedas a posicionar las páginas de un sitio web. Si caes en la trampa de crear enlaces en tu página desde cualquier otro sitio web sin importar cuál sea, puedes ser penalizado por Penguin.

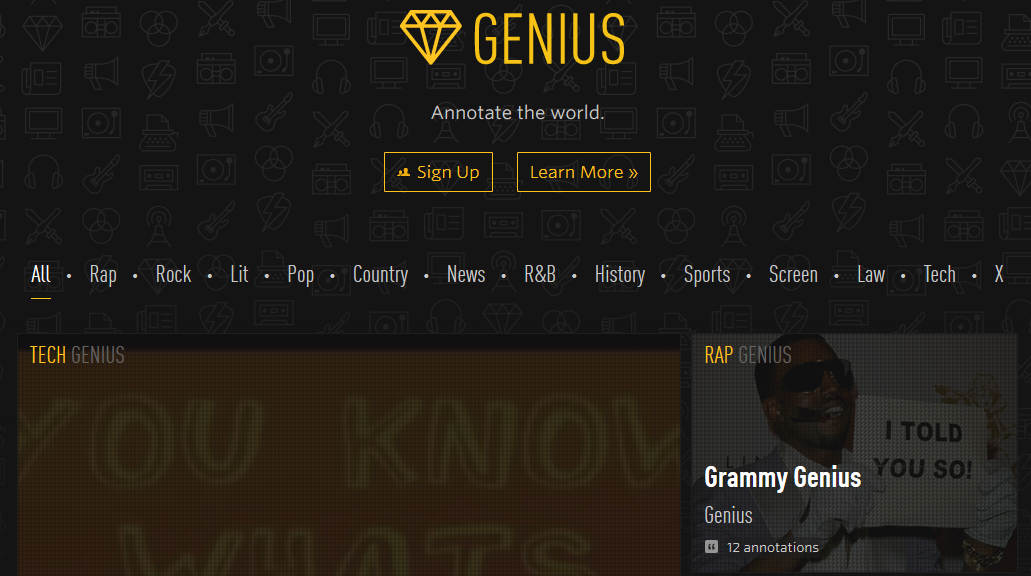

Rap Genius, un sitio web dedicado que interpreta letras de canciones y poesía fue penalizado porque Google descubrió que estaban usando esquemas de enlaces para manipular su posicionamiento.

Moraleja: Evita cualquier forma de esquema de enlaces. El riesgo simplemente no vale la pena.

ii). Sobreutilización de Palabras Clave – Matt Cutts ya había advertido sobre la saturación de palabras clave relevantes en tu sitio web. No importa lo detallado que sea el contenido de tu sitio ni lo fácil de navegar que sea, Penguin se dará cuenta si sobreutilizas palabras clave y te penalizará. En la mayoría de los casos, es fácil ver el porqué, especialmente si ya has visto una página con sobreutilización de palabras clave. Este es un ejemplo:

Comprar un regalo de San Valentín para tu cónyuge es un gran paso a tomar. Este año, el regalo de San Valentín debería ser un camino directo para expresar cuánto amas a tu pareja. Asegúrate de elegir muy bien el regalo de San Valentín. Pero no te detengas ahí. Conviértelo en una costumbre de siempre demostrar amor a tu cónyuge, bien sea en una celebración de San Valentín, navidad, o cualquier otra. Por ejemplo, si muestras amor hoy, vivirás para ser amado. ¿Estás listo para elegir el mejor regalo de San Valentín?.

¿Ves cuántas veces se usa la frase clave en este fragmento de contenido? Eso es sobreutilización de palabras clave y va en contra de las Directices de Google para Webmasters.

No sobreutilices palabras clave en tu contenido. No intentes manipular tu clasificación o posicinamiento. Si una palabra clave en particular no suena bien, o no suena natural en el contenido, no la uses.

Nota: Las palabras clave siguen siendo relevantes en la era post Panda y post Penguin. Simplemente concéntrate en la intención de tus palabras clave y escribe contenido que apele a las emociones de las personas y solucione sus problemas. El SEO efectivo siempre ha sido de esa manera. Es así de simple.

iii). Excesiva Optimización – Según KISSmetrics, “El SEO es estupendo, pero mucho SEO puede causar sobreoptimización”. Si sobreoptimizas tus textos de anclaje, por ejemplo, puedes ser penalizado por Penguin. La mejor manera de abordarlo es incorporar marketing de redes sociales y ganar enlaces orgánicos a tu páginas.

En abril de 2012, Google lanzó otra actualización a su algoritmo que penalizaban grandes sitios web que sobreoptimizaron palabras clave y textos de anclaje, haciendo de esta manera esquemas de enlaces y buscando otras formas de manipulación de enlaces.

Una señal de que puedes estar sobreoptimizando tu contenido, es tener textos de anclaje que en su mayoría sean palabras clave y que sean para enlaces internos, es decir, que dirijan a páginas en tu mismo sitio web.

Este es un ejemplo:

Aprende más sobre los portátiles Hp Pavilion 15 y sus características.

(Dirige a: ejemplo.com/hp-pavilion-15-portatiles.htm)

Otro ejemplo es:

¿Conoces el mejor protector de iPhone hecho a mano para ti?

(Dirige a: ejemplo.com/mejor-protector-iphone-hecho-a-mano)

Nota: Cuando tu texto de anclaje dirige a una página con una URL exacta, puede crear buen SEO. Pero cuando esto se hace muchas veces, puede ser penalizado por sobreoptimización.

iv) Enlaces antinaturales – Lo curioso sobre los enlaces antinaturales o fuera de contexto, es que no se ven bien para nadie – ni para tus lectores, ni para Google. Estos enlaces pueden aparecer en sitios que no tienen nada que ver con el tema. La empresa Cardstore perdió su posicionamiento debido a enlaces antinaturales que aparecían en directorios de artículo (sitios que coleccionan artículos sobre distintos temas).

Es cierto que esos enlaces funcionaron en el pasado y que sitios web grandes eran los que mejor los usaban. Pero Google Penguin destruyó el campo de juego, por así decirlo, y de este modo se acabaron los beneficios obtenidos por ese duro trabajo. La moraleja de la historia es: Tus enlaces deben ser naturales.

Cuando compras o intercambias enlaces con alguien, lo que sucederá muy seguramente es que los textos de anclaje o enlaces sean totalmente irrelevantes. Aquí hay otro ejemplo práctico: Overstock.com descendió en posicionamiento web cuando Google descubrió que el sitio intercambiaba descuentos por enlaces terminados en .EDU.

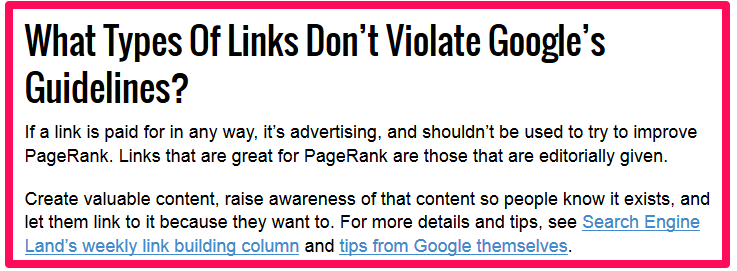

Yo no recomiendo la compra de enlaces, pero si tienes que hacerlo, asegúrate de que el sitio que refiere el enlace, sea relevante, con autoridad y que los enlaces sean naturales. Aquí hay una mejor explicación hecha por Search Engine Land:

Cómo funciona Penguin – El algoritmo Penguin es un filtro de búsqueda que depende de las actualizaciones frecuentes del algoritmo de Google y de los intentos por penalizar enlaces spam y enlaces no naturales.

El código Penguin simplemente busca practicas agresivas de creación de enlaces que tienen por objetivo manipular los resultados de búsquedas para obtener mejor posicionamiento.

Por ejemplo, si estás creando muchos backlinks de manera rápida para tu nuevo sitio, Google puede fácilmente detectar que estás siendo agresivo y proceder a penalizar tu sitio por esto, o incluso eliminarlo de sus búsquedas indexadas.

Recuerda, cualquier enlace que construyas ahora o en el futuro con la intención de mejorar tu posicionamiento web, viola las Directrices de Webmaster de Google.

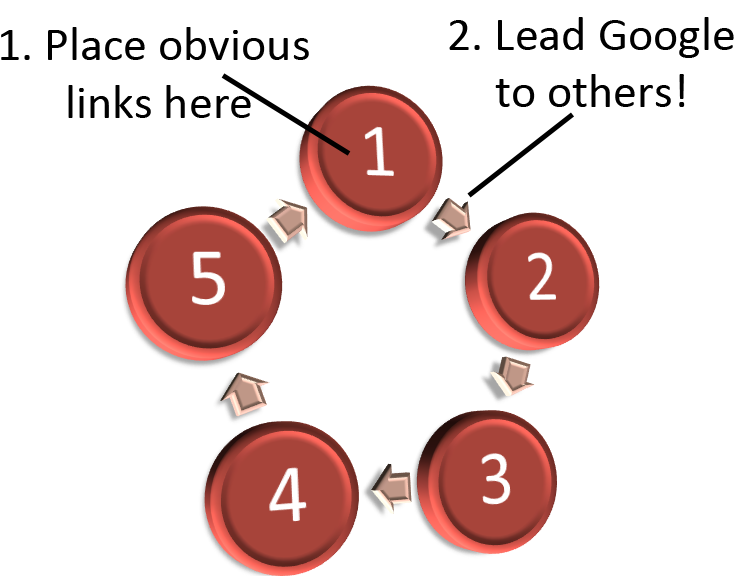

El intercambio de enlaces, los enlaces comprados y otras técnicas que se lleven a cabo con la intención de burlar el algoritmo de Google, son todas malas practicas de SEO. Puede que funcionen un tiempo, pero tarde o temprano Google se dará cuenta. Y más importante aún, evita ruedas de enlaces (‘link wheels’) o intercambiar enlaces para manipular los resultados de búsquedas.

La correlación entre Panda y Penguin – Cuando dedicas tiempo a mejorar tus páginas con poco contenido y de baja calidad, estás creando un sitio hacia el cual otras personas se sentirán atraídas. Y esa es la relación entre las actualizaciones de Panda y Penguin.

Ten presente que aun si tu página tiene contenido único, útil e in-depth o bien detallado, aun así te enfrentas a una penalización de Penguin si tus enlaces son de baja calidad.

¿Cuál es la diferencia entre Panda y Penguin? La actualización Panda se centra principalmente en el contenido, mientras que la actualización Penguin es para eliminar los enlaces agresivos y spam que buscan manipular el posicionamiento en los resultados de búsqueda.

Es importante estar al tanto de ambas actualizaciones. Si tu sitio es penalizado por Panda, por ejemplo, es posible que Penguin también afecte a tu sitio web. Algunos SEOs y dueños de sitios web, han experimentado múltiples penalizaciones, mientras se preguntan qué pasó con su posicionamiento web.

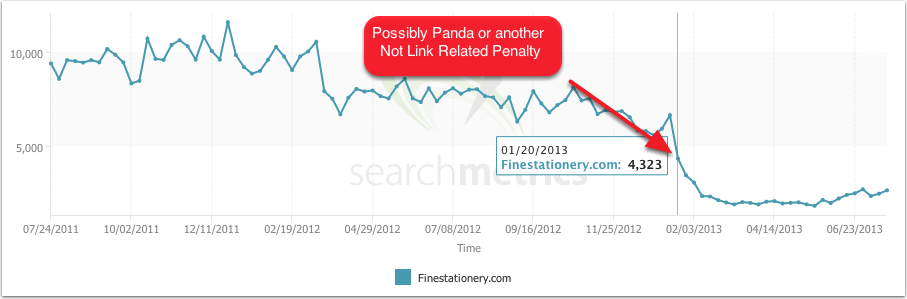

Un buen ejemplo de esta interrelación entre Panda y Penguin, es lo que pasó en el sitio Finestationery.com. Cuando empezó a perder posicionamiento, no era claro qué estaba sucediendo. ¿Estaba siendo penalizado por Panda o Penguin?

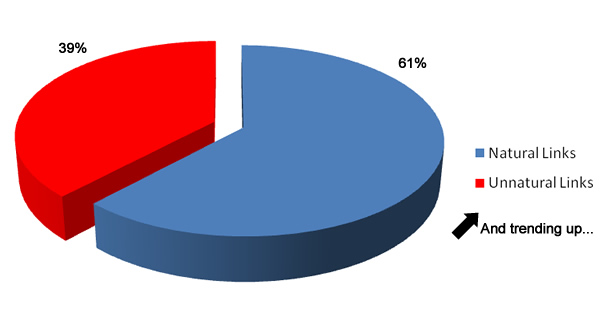

Cómo evitar una penalización de Penguin – Si no quieres ser penalizado por Penguin, entonces haz que tu blog reciba enlaces naturales. Search Engine Watch compartió un caso de estudio de un sitio donde descubrieron una mezcla de 61% de enlaces naturales y 39% de enlaces no naturales y explicaron los pasos que tomaron para mejorar el sitio.

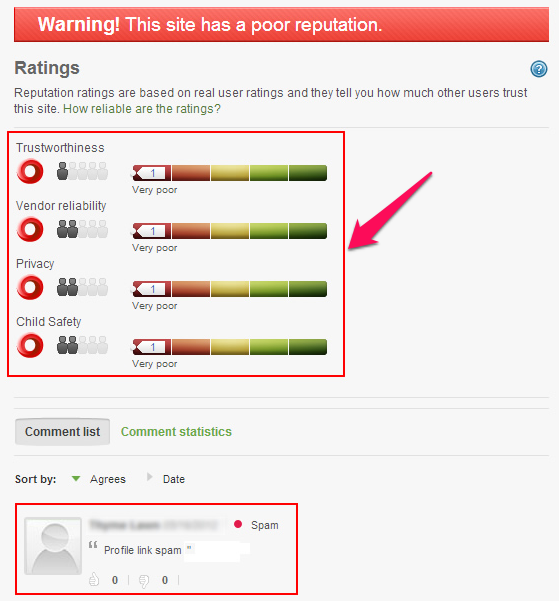

Puedes usar Web of Trust (Sitio de Confianza, en español. WOT por sus siglas en inglés) para medir el grado de confianza que tienen las personas en tu sitio web. Si tu puntuación de WOT, es baja, entonces tienes cosas por hacer para mejorar, lo que lleva al mismo punto: producir buen contenido y crear interés y conexión en redes sociales.

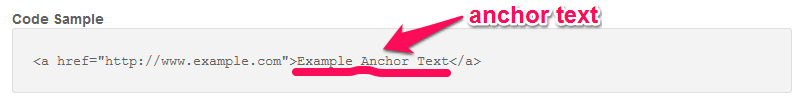

Entendiendo los textos de anclaje: Un texto de anclaje es simplemente el texto con un enlace en el que puedes hacer clic. El hipervínculo que lo conecta está escondido. No puedes ver la URL de destino hasta que hagas clic sobre ese texto, o pases el cursor encima de él, pero el texto enlazado es visible en la página.

Resulta que un excesivo uso de estos textos de anclaje con las palabras clave exactas en ellos, pueden disparar una penalización de Penguin. Darse cuenta de esto fue una sorpresa para los SEOs. Durante un buen tiempo, los SEOs se enfocaron en crear textos de anclaje que concordaban exactamente con las palabras y frases clave objetivo con el fin de ayudar a crear enlaces.

Después de lanzar Penguin, muchos sitios web vieron un descenso en sus puntuaciones de posición y en su tráfico orgánico. La razón es simple: uso excesivo de textos de anclaje que concordaban precisamente con las palabras clave.

De hecho, los textos de anclaje juegan un rol importante en la actualización Panda de Google. Por esto es importante crear los enlaces correctos, usando palabras relevantes y genéricas, para reducir el riesgo de recibir una penalización de Google.

Hay otro tipo de manipulación de enlaces y contenido en los cuales se centra la actualización Penguin, que pueden también conllevar a una penalización de Google:

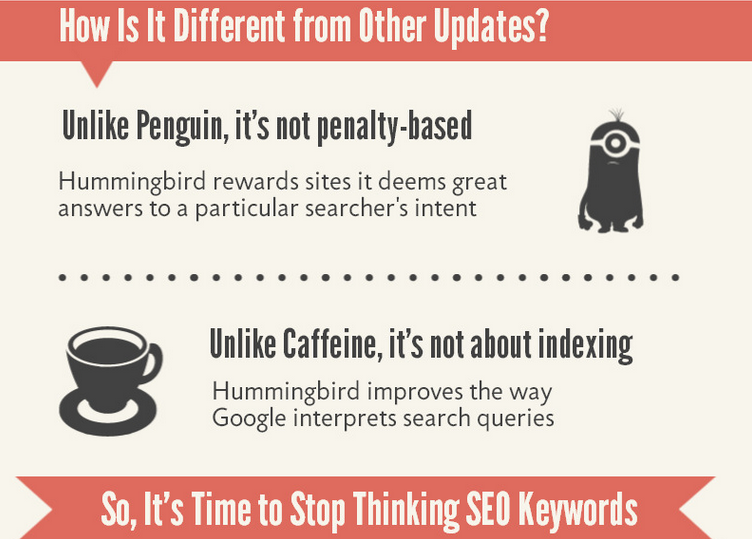

Los cambios Hummingbird al Algoritmo de Google

El 26 de septiembre de 2013, Google lanzó una de las más importantes mejoras a su algoritmo de búsquedas registradas hasta el momento. Hummingbird le da a Google una plataforma “precisa y rápida” donde los usuarios pueden encontrar fácilmente lo que están buscando cuando escriben una palabra clave en el motor de búsqueda.

En otras palabras, esta actualización del algoritmo de Google está diseñada para mejorar los resultados que muestra cuando se busca una palabra clave específica – y no solo entregar resultados con esa palabra clave, sino también mostrar lo que llamamos «la intención de la palabra clave». De cierta manera, Panda y Penguin fueron actualizaciones continuas al algoritmo existente, mientras que Hummingbird es un nuevo algoritmo.

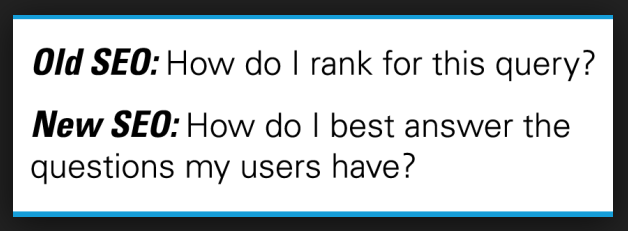

Este nuevo algoritmo emplea más de 200 factores de clasificación para determinar la relevancia y calidad de un sitio particular. Hummingbird crea, por así decirlo, una línea divisoria para distinguir el viejo SEO del nuevo.

Ahora nos concentramos en los usuarios, no en las palabras clave. Por supuesto, la búsqueda de palabras clave seguirá siendo relevante, especialmente cuando quieres explorar un nuevo mercado.

Pero cuando es hora de producir contenido que de verdad resuelva problemas para las personas, entonces debes enfocarte en responder preguntas. En el SEO de hoy, empieza por el usuario, trabaja con contenido de calidad y después mide el impacto de los enlaces de tu sitio web.

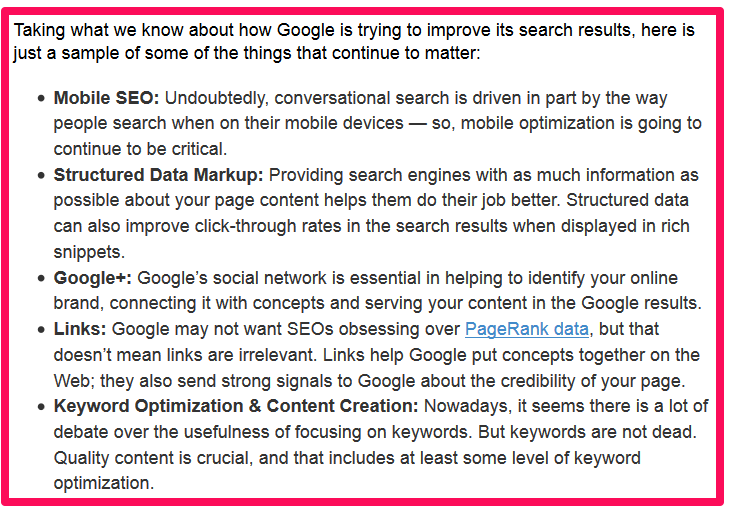

Jim Yu, CEO y fundador de BrightEdge, explica alguno de los elementos que aún siguen importando cuando se hace SEO en la era de Hummingbird. Yu aún cree que las palabras clave seguirán ocupando un puesto predominante de SEO, pero con el propósito de ofrecer contenido de calidad.

Nota: Hummingbird usa frases clave long-tail, en lugar de las palabras clave de raíz o de base. Los sitios que usan estas frases clave han tenido mucho éxito. 91% de mi tráfico proviene de palabras clave long tail.

Marcus Sheridan ha usado y sigue usando, palabras clave long tail para traer visitas orgánicas al blog de su empresa River Pools Company.

Si quieres aprender más detalles sobre Hummingbird y cómo ha afectado al SEO desde su lanzamiento en 2013, la siguiente infografía de Search Engine Journal te ayudará:

Haz clic aquí para ver la infografía completa.

Elementos de Hummingbird: Dado que Hummingbird no es simplemente una actualización del algoritmo como Panda y Penguin, sino más bien un total cambio enfocado en servir mejores resultados de búsqueda a los usuarios, deberías tener presente algunos de sus más importantes elementos. Para que todos estos elementos puedan funcionar juntos y trabajar apropiadamente, tienes que entender a tu audiencia.

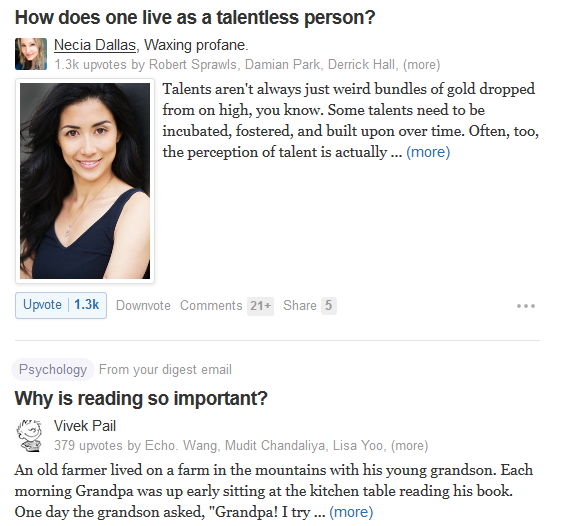

Búsqueda Conversacional

La búsqueda conversacional es el elemento principal del algoritmo Hummingbird.

No importa cómo sea tu nicho de mercado, hay palabras clave conversacionales que te permitirán crear contenido de alto valor. Hoy en día las personas buscan en la web en un modo más conversacional. El 44% de los marketers buscan posicionamiento de palabras clave. Pero el SEO es más que palabras clave.

Google extrae información de su Gráfico de Conocimiento y de Señales Sociales para entender el significado de las palabras en una página web.

¿Por qué es Quora un sitio tan popular? Seguramente hay muchas razones, pero su popularidad se debe en gran parte a un simple hecho: Quora ofrece expertos de diferentes áreas que voluntariamente responden preguntas en un modo conversacional.

Quienes tienen sitios web y quienes escriben contenido deben alinear sus palabras clave y contenido para que coincidan con la forma en que las personas hablan y buscan información. Las palabras clave conversacionales son preguntas que contienen palabras clave. Te encontrarás con ellas cuando realices una búsqueda.

Tu landing page debe ser capaz de responder la pregunta que motivó la búsqueda en primera lugar. Por ejemplo, digamos que alguien está buscando «mejor tratamiento de artritis en NJ» (New Jersey). Entonces tu página de contenido debe tener esa información para el usuario y no redirigirlo a otro sitio de cuidado de artritis ubicado en Los Ángeles.

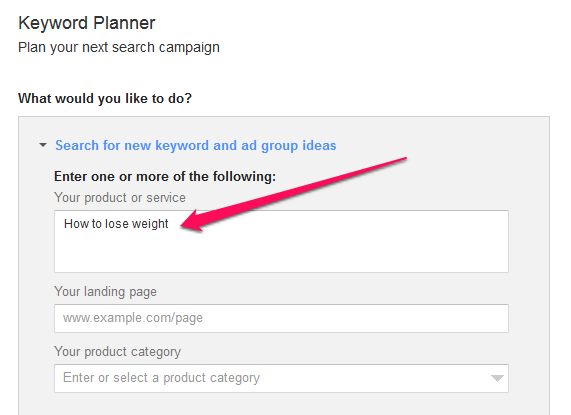

Así que, ¿cómo encuentras palabras clave conversacionales, es decir, preguntas con palabras clave y palabras clave long tail?

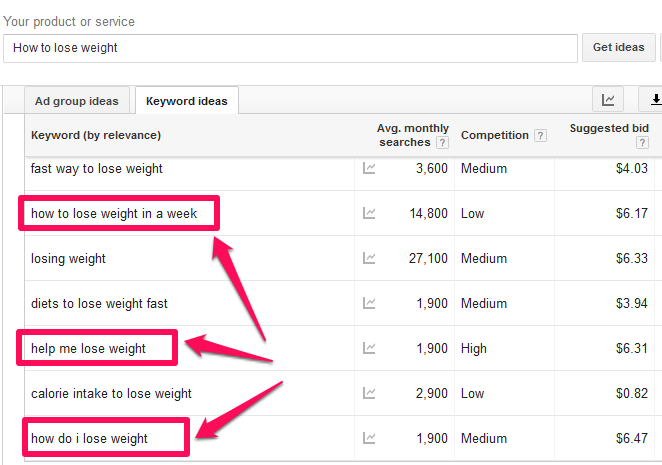

Paso #1: Abre Google Keyword Planner. Escribe una palabra clave relevante que inicie con la pregunta «cómo», por ejemplo, «cómo perder peso».

Paso #2: Identifica las palabra clave long tail.

En la captura de pantalla anterior, puedes ver que las personas están buscando información con varias palabras clave conversacionales. Ellos quieren respuestas de ti. Es tu trabajo proveer esas respuestas de una manera conversacional.

Las frases clave que empiezan con la pregunta “cómo» y el contenido en particular que las incluye, responderán mejor a las preguntas de tus usuarios, que como resultado aumentarán el engagement. Siguiendo nuestro ejemplo, podrías escribir un caso de estudio de alguien que perdió peso, de una manera que sea útil, interactiva y detallada.

Cerca del 87% de mis blogs incluyen tutoriales que responden a los «cómo» que buscan muchas personas y esa ha sido la razón de mi éxito.

Recuerda: Después de Hummingbird, los usuarios son la clave.

Copyblogger también entiende cómo complacer a su audiencia. Sus publicaciones en el blog tienen títulos magnéticos y por naturaleza generan conversión. Además, ellos entienden su competencia, tienen un sitio que es mobile responsive (se adapta a dispositivos móviles) y usan redes sociales para obtener más resultados. Todos estos factores hacen que Google se sienta complacido de enviar tráfico al sitio de Copyblogger.

El contenido es el nuevo anuncio. Los anuncios tradicionales tiende a interrumpir a los usuarios, pero el contenido útil e interesante los atraerá y convertirá en clientes recurrentes.

Esa es toda la esencia del marketing de contenidos – y ha sido mi arma secreta para hacer crecer mis empresas de software. Puede ser que no comprendas completamente las políticas de Google, pero sigue el consejo de Jenna Mills y tu sitio no solo evitará penalizaciones de Google, sino que también disfrutará de tráfico y un mejor posicionamiento orgánico.

La Actualización Pigeon de Google

Hasta ahora hemos hablado de Panda, Penguin, Hummingbird y cómo estas actualizaciones del algoritmo de Google afectan a los sitios web y a quienes quieren mejorar el posicionamiento web sin ser penalizados.

Sin embargo, hay otras actualizaciones y cambios que han tenido lugar desde el lanzamiento de Panda en 2011. Especialmente en Julio de 2014, cuando se hizo la actualización Pigeon. Para más información sobre Pigeon, mira el post que escribí antes, sobre todo lo que necesitas saber de la actualización Pigeon.

¿Cómo de grande será el impactó de Pigeon en el SEO y en el marketing? Según Search Engine Land, 58% de marketers locales definitivamente cambiarán sus tácticas tras la actualización Pigeon.

Conclusión

Espero que este artículo sobre el Algoritmo de Google te haya ayudado a entender completamente los más grandes cambios en Google: Panda, Penguin, Hummingbird y Pigeon. Estas actualizaciones y cambios al algoritmo han revolucionado el SEO.

Finalmente, todo lo que tienes que hacer es crear enlaces de una manera escalable y orgánica y centrarte en proveer el contenido con la mejor calidad que puedas (bien sea publicaciones escritas, o creativas infografías), para aumentar el tráfico de tu blog.

¿Qué efectos de las actualizaciones en el algoritmo de Google has notado en tu página web?

Comentarios (1)